近期,IEEE 国际计算机视觉与模式识别会议(Conference on Computer Vision and Pattern Recognition)CVPR 2025 公布论文录用结果。

近期,IEEE 国际计算机视觉与模式识别会议(Conference on Computer Vision and Pattern Recognition)CVPR 2025 公布论文录用结果,社交平台 Soul App 技术论文《Teller: Real-Time Streaming Audio-Driven Portrait Animation with Autoregressive Motion Generation》(《基于自回归动作生成的实时流式音频驱动人像动画系统》)被接收。

Soul App 团队在论文中提出了一个新的面向实时音频驱动人像动画(即 Talking Head)的自回归框架,解决了视频画面生成耗时长的行业挑战外,还实现了说话时头部生成以及人体各部位运动的自然性和逼真性。此次论文的入选,也证明了 Soul App 在推动多模态能力构建特别是视觉层面能力突破上取得了阶段性成果。

CVPR 是人工智能领域最具学术影响力的顶级会议之一,是中国计算机学会(CCF)推荐的 A 类国际学术会议。在谷歌学术指标 2024 年列出的全球最有影响力的科学期刊/会议中,CVPR 位列总榜第 2,仅次于 Nature。

根据会议官方统计,本次 CVPR 2025 会议总投稿 13008 篇,录用 2878 篇,录用率仅为 22.1%。相较 2023 年(25.8%)、2024 年(23.6%),录用率的持续下降也凸显了 CVPR 不断严格的审核标准,以及论文入选竞争的逐年激烈。

对 Soul 而言,研究成果再次入选国际顶级会议,证明了团队在 AI 领域,特别是多模态方向的自研能力受到行业和学术界认可。2024 年,Soul 多模态情感识别研究论文《Multimodal Emotion Recognition with Vision-language Prompting and Modality Dropout》(《基于视觉语言提示与模态暂退的多模态情感识别》),入选 ACM 国际多媒体会议(ACM International Conference on Multimedia,ACM MM 2024)上组织的多模态与可靠性情感计算研讨会 MRAC 24。而在人工智能领域顶级的国际学术会议之一——国际人工智能联合会议组织的第二届多模态情感识别挑战赛(MER24)上,Soul 技术团队还在 SEMI(半监督学习)赛道获得第一名。

作为较早思考将 AI 应用于社交领域的平台,2016 年 Soul 在上线后快速推出了基于 AI 算法的灵犀引擎,重构关系网络发现的新模式,受到了广大用户的热烈反馈,也坚定了平台对 AI 持续投入的发展路线。2020 年 Soul 开始启动 AIGC 技术研发工作,在智能对话、语音、3D 虚拟人等方面拥有前沿积累,并较早将重点聚焦在多模态方向。

自 2023 年推出自研语言大模型 Soul X 后,Soul 已陆续上线了语音生成大模型、语音通话大模型、音乐生成大模型等语音大模型能力。目前,Soul AI 大模型能力已整体升级为了多模态端到端大模型,支持文字对话、语音通话、多语种、多模态理解、真实拟人等特性,能够实现更接近生活日常的交互对话和「类真人」的情感陪伴体验。

在 Soul 看来,AI 融入社交场景,除了需要 AI 介入内容表达以及关系的发现、建立、沉淀等环节,提高社交效率和社交体验,同时也需要 AI 作为交互对象向个体提供情绪价值。而这要求团队必须加快提升 AI 的感知能力和交互能力,即需要在语音、视觉、NLP 的融合上下功夫,让用户能实时与具备形象、表情、记忆的 AI 多模态交互,而这也是更接近真实社交互动的方式。

在近期接受媒体采访中,Soul App CTO 陶明这样解释团队关注视觉交互的逻辑,「从交互的信息复杂度来讲,人和人面对面的沟通是信息传播方式最快的,也是最有效的一种。所以我们认为在线上人机交互的过程当中,需要有这样的表达方式。」

此次论文的研究成果正是 Soul 在融合视觉的多模态交互方向的积极探索。在论文中核心介绍了 Soul 团队为提高视频生成效率以及生成效果的拟人性、自然度所提出的创新方法。

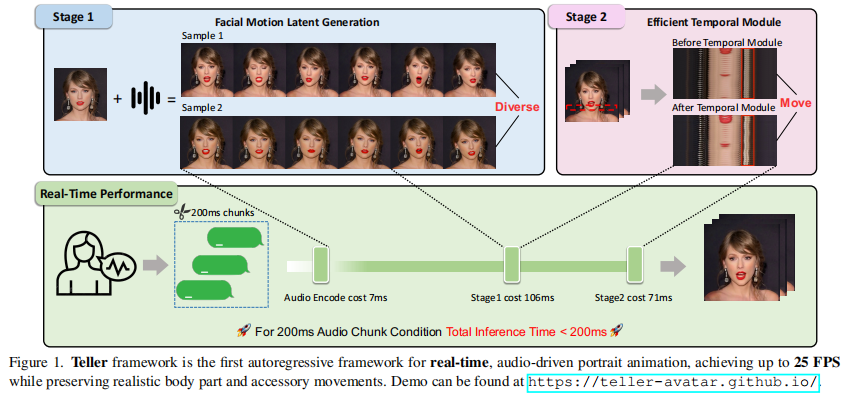

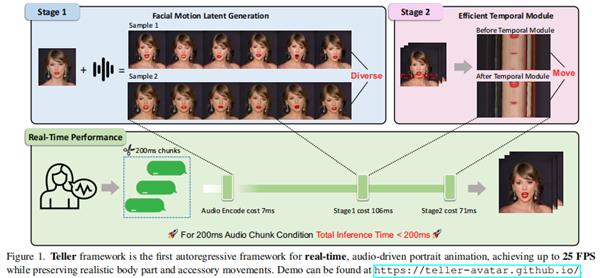

该论文的动机是解构 diffusion-base 的模型关键步骤,用 LLM 和 1step-diffusion 进行重构,融合视频模态,使 SoulX 大模型成为同时生成文字、语音、视频的 Unified Model。

具体而言,将 talking head 任务分成 FMLG(面部 Motion 生成)、ETM(高效身体 Movement 生成)模块。FMLG 基于自回归语言模型,利用大模型的强大学习能力和高效的多样性采样能力,生成准确且多样的面部 Motion。ETM 则利用一步扩散,生成逼真的身体肌肉、饰品的运动效果。

实验结果表明,相比扩散模型,该方案的视频生成效率大幅提升,且从生成质量上来看,细微动作、面部身体动作协调度、自然度方面均有优异表现。

在 Soul 多模态大模型能力方向基础上,该方案的提出将有助于 AI 构建实时生成的「数字世界」,并且能够以生动的数字形象与用户进行自然的交互。

此前,Soul 基于自身的多模态大模型能力上线了语音交互功能,受到了用户的热烈讨论和积极反馈。如今,从语音到视觉的模态升级,也意味着交互方式的颠覆式改变。

后续,Soul 将把最新的 AI 能力尽快落地到站内多元场景中,如即将上线的实时视频通话能力将融入平台的 AI 虚拟人情感化陪伴体系「虚拟伴侣」、多对多互动场景「群聊派对」等功能中,进一步提升平台 AI 虚拟人的交互能力,以及人机交互的在场感和情感温度,为用户带来有趣、温暖的社交体验。

来源:互联网