月之暗面等大模型研发者撰文忆开发历程,知乎成 AI「思维链开源地」

「发完论文,上知乎亲自答」,人工智能研究者也不例外。

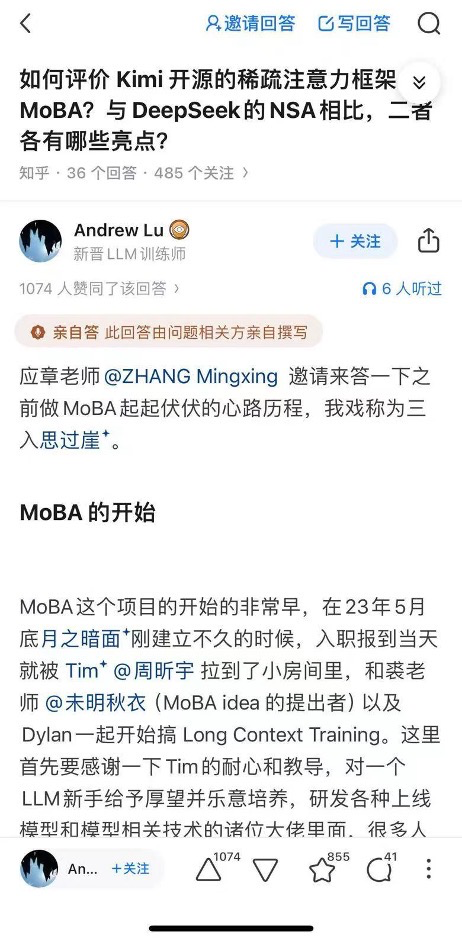

近日,DeepSeek 和月之暗面先后发布最新研究论文,一场聚焦大模型核心技术的深度讨论随之在知乎展开。2 月 20 日,月之暗面开源 MoBA 框架研发人员鹿恩哲、苏剑林分别在知乎讲述了研发思路,与此同时,微软研究院、清华大学团队以及阶跃星辰开源模型参与者,均发文分享研究了各自成果与历程。这被业界称为继模型开源、论文开源之后的一次「思维链开源」。

鹿恩哲的知乎用户名称为「Andrew Lu」,签名为「新晋 LLM 训练师」,他以「三入思过崖」为比喻,拆解了该模型框架研发过程中的三次关键突破和思维转变:首次思过崖是「将 MoBA 从串行两层注意力方案改并行的单层注意力方案」;第二次思过崖则从 2023 年 9 月一直持续到了 2024 年年初,为此团队参与者进行了多番激烈讨论;最后一次思过崖则鉴于「MoBA 本身优秀的数学性质」,没让整个项目付出巨大的沉没成本。

MoBA 项目中的另外一位参与者、知乎答主苏剑林,也发文补充了一些信息,在他看来,MoBA 值得业界继续延伸讨论下去,「我觉得 MoBA 并不单单是一次在 Sprse Attention 上的成功尝试,它的有效性还可能蕴含着一些值得深思的本质原理在里面,期待大家的集思广益」。

「这种试错的心路历程,是比技术报告都珍贵的经验」,一位知乎用户如此评价鹿恩哲的分享。业界普遍认为,模型参与者亲自拆解研发历程,是继模型开源、论文开源之后的一次「思维链开源」。知乎上不断有 AI 领域的从业者参与讨论,撰文分享各自大语言模型的研究历程。

微软亚研院高级研究员曹士杰在知乎撰文表示,其团队去年研究的工作也是同 sparse attention(稀疏注意力)有关。面壁智能联合创始人、清华大学计算机系副教授刘知远的团队在 2024 年发表过 InfLLM,其中也涉及一种稀疏注意力改进,并被 DeepSeek 此次发表的 NSA 论文所引用,InfLLM 项目参与者、知乎答主「xcjthu」撰文表示,NAS 最精彩的部分还是软硬一体化的设计,「正如 Deepseek-V3 带给大家的震撼一样,我认为 NAS 的硬件亲和性是这篇论文最精彩的部分」。

阶跃星辰于 2 月 17 日开源了两款多模态大模型,分别是视频生成模型 Step-Video 和音频生成模型 step-audio。其中视频生成模型的参与者、知乎答主「hzwer 黄哲威」即于知乎撰文,详尽介绍了这款大模型的研究历程,他称,「Step-Audio 项目主要就是想发挥大数据、大模型的类似大语言模型结构威力」。

知乎囊括了最广泛的互联网、AI、机器人等科技领域的从业者,成为从业者们最青睐的交流场所和思想碰撞的前沿阵地。在月之暗面 MoBA 与 DeepSeek NSA 的「撞车」发布之后,众多开发者选择在知乎分享大模型研究「踩坑」实录,不仅代表着开源社区与学术生态的深度融合,更印证了知乎作为中国 AI「思维链开源地」的独特平台价值。