以数据消费为目标,重建「数据中台」

数据飞轮,是今年大模型带火的一个典型词汇,通过客户在应用程序中输入的提示词这样的数据反馈,使大模型快速迭代。今年初,数据飞轮也曾一度被视为 OpenAI 最重要的先发优势。

但在 All in 大模型的下半年,数据飞轮成为了大模型厂商最头疼的事情。此前在极客公园举办的一场大模型研讨会中,不少创业者表示,「用户都看重数据资产,不愿意把数据拿出来,模型厂商帮助客户训好模型,做本地部署,做完了『净身出户』,数据飞轮很难建立起来」。

从 A/B 测试里跑出来的今日头条,基于数据分析选品、调度的抖音直播,火山引擎数据平台拥有这两个互联网最艳羡的业务实践,火山引擎如何看待大模型的数据飞轮问题?

带着这样的好奇,极客公园在 9 月 19 日 V-Tech 数据驱动科技峰会上,采访了火山引擎总裁谭待。他表示,大模型的数据飞轮问题首先要合规,其次,很多企业愿意与模型厂商共创,从而可以让大模型厂商的大模型数据飞轮转起来。

火山引擎 V-Tech 数据驱动科技峰会|来源:火山引擎

另一方面,在数据平台的产品层面,火山有更多的数据飞轮实践。

峰会上,谭待和字节跳动数据平台负责人罗旋,介绍了火山引擎在数据平台层面接入的大模型功能探索。其中,在类 BI(Business Intelligence,商业智能)产品、自动驾驶舱等产品中引入了 AI 助手;在数据管理产品中引入了 AI 自动补全代码和修正代码等功能;目前,相关数据产品已启动邀测。据悉,这几款产品的AIGC功能背后,是基于火山自己的大模型——云雀(目前在内测中)。上个月底,云雀大模型通过了《生成式人工智能服务管理暂行办法》备案。

事实上,大模型在数据类产品的落地,还有一定距离。

6 月以来,不少数据产品都引入了 AI 助手这样的功能,目前产业界普遍仍在打磨落地中,要实现任何自然语言精准「召唤」出想要的数据形式,还需要几年的探索时间。火山引擎总裁谭待也表示,真正有比较好的 AI 原生应用出来,可能要等到底座模型本身至少具备GPT3.5+以上水平,才会清晰一些。

但在理念上,火山引擎提出了不同的数据飞轮理念,数据驱动最终是一定要落在企业不同人员对数据的消费上,以此来建设数据产品,把数据「推」到最广泛的数据消费者面前,最终形成基于数据分析的一致行动。这能解决近年来饱受争议的数据中台难落地的问题。

关于上述问题,谭待和罗旋接受了包括极客公园的采访,以下是对话节选:

数据,必须被「消费」

问:峰会上推出的找数助手、开发助手、分析助手几款工具,用户会以什么样的方式获取这些服务?

罗旋:因为 AI 本身也在快速发展过程中,产品经过一段实践,不能算是成熟的状态,我们希望一点点逐渐打磨产品。前期先邀测,不会大规模放开,希望有一些客户能够深度跟我们共创,更成熟以后,再大规模对外公开。

问:这些AI助手用了什么大模型?

罗旋:我们现在主要依赖于字节本身有一个云雀大模型,以及火山方舟 MaaS 平台上有一些合作伙伴的大模型。

问:怎么理解「以消费为核心」的数据驱动?

谭待:回到最大的根本,做这件事情,还是希望把目标定清楚,最后其实是以数据消费为目标来做这个事情。跟过去五六年业界讲的数据中台的概念相比,这是一个更大的升级,而且是更有效解决企业数据产生价值的问题。

否则,很多企业投入大量的资源,建完之后有数据,但是没有利用起来,本质就是没有想清楚最终应该围绕什么来做这件事情。以前我们做建设的时候,目标是有偏差的,比如我建一个中台其实不是目标,是实现数据驱动的一个手段。

所以我们提出了数据消费、数据飞轮这样的逻辑。企业建设数据时,应该把数据消费作为目标,比如峰会讲的两个 80%:一是 80% 的企业员工能够用到,二是能覆盖到 80% 的分析场景。

围绕数据消费,我们的体系叫数据飞轮,数据飞轮上层是跟应用相关,这些产品里面大部分确实是 SaaS 的形态,也有一些会是 PaaS 的形态。下一层是数据资产的建设,这些主要是 PaaS 为主,通过数据消费这个事情端到端应用起来,就能解决过去企业数据建设过程中,数据团队和业务团队互相不理解导致最后效果不好的问题。

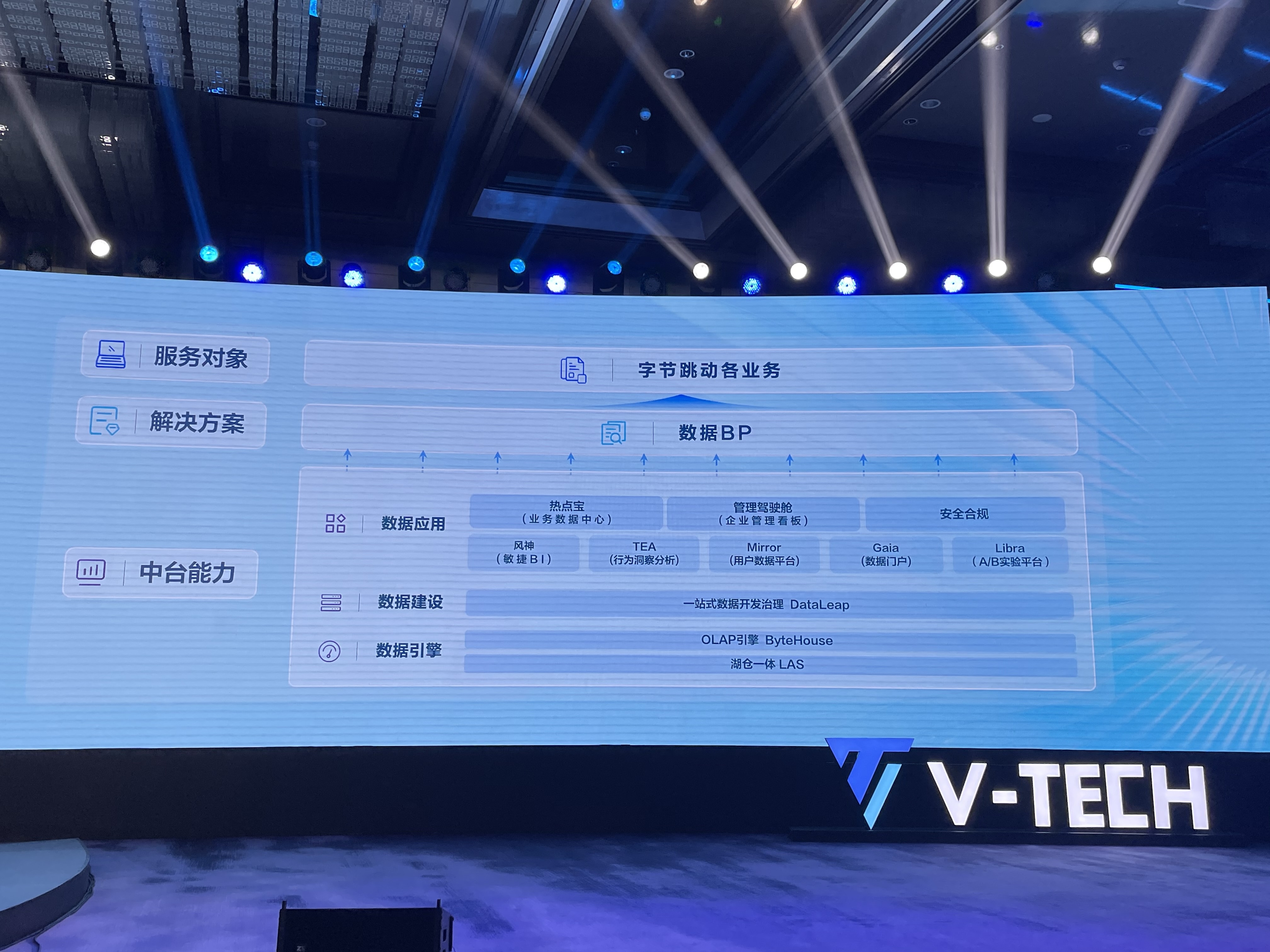

火山引擎全套数据平台产品|拍摄:极客公园

问:火山引擎一整套数据飞轮的产品,如果跟 SnowFlake 相比的话,有哪些相同的地方,有哪些不同的地方?

罗旋:SnowFlake 本质上更多是数仓的引擎,公司做大以后也尝试着往更多数据分析这边去走,但是更多是从基础层的引擎往上做。

我们切入的角度不一样,我们更强调业务,比如 AB 测试,SnowFlake 没有,我们偏数据飞轮下面的轮子,偏数据资产和数据建设底层的部分,更强调两个轮子兼备。

从业务需求来说先做应用,发现下一层可能有数据质量包括治理、资产的问题,再建下一个轮子,可以更灵活,更有选择性一些,这是一个比较大的区别。

谭待:可以类比一个概念,叫 DevOps,以前 Dev 和 Ops 完全分开的,所以很割裂。其实数据里面也有这个问题,你的应用和建设也是完全分开的,我们讲数据飞轮有点像 DevOps,我要把数据应用和数据资产合在一起。

问:传统企业想做数字化,或者一开始企业也注重数据,但是建设的不是特别好。如果这种情况下,希望能借助数据飞轮这个工具,会不会有一些摩擦力?

谭待:我们这些年也服务了很多所谓的传统行业,像制造业、金融、零售等等都有。这几年大家已经很重视数据建设,不是五年前或者七八年前大家觉得这事不是特别重要。

现在最大的挑战是,建设完发现数据用不起来,因为建设过程中跟他的业务目标是脱离的,是有很多报表、很多系统,但是都用不起来。这也是我们为什么提数据飞轮、数据消费的原因,得重新审视怎么建这个事情,不然建再多的中台也没用,这是这个阶段我们需要改变的事情。

问:数据飞轮相比传统企业数字化工具和数据中台的升级点到底在哪?

罗旋:最大的一点是看业务的痛点,第一步到底做什么?传统数据中台第一步是把数据建设好,数据资产弄好,到底有多少数据是一个相对整齐、统一、高质量地呈现出来。

数据飞轮,很大程度上先聊业务,业务上有什么诉求,看数据可以在里面起到多大作用,再看具体应该用什么样的解决方案,什么样的产品。

比如有客户说我们做了小程序的页面优化或者文案优化,他的业务痛点非常明确——通过文案的优化提高营销的转化率。相应地,我们提供的方案就是做 AB 测试。如果是另一种问题,比如说数据清洗、数据质量,我们可能需要提供数据资产管理、数据治理的工具,这是非常不一样的。

传统数据中台上来先不聊这些,先给你一个全家桶,先把这些做完。做完之后有什么用?这些事当时没有考虑,所以会遗留大量的工程后面推进不下去了,这是本质区别。

谭待:比如他已经投入了数据中台建设,他再用数据飞轮也是一个继承关系,不需要全部推倒重来,这对于企业来说也是一个很好的方式,已有的投入也可以得到延续。

大模型的数据飞轮,有解吗?

问:大模型时代,数据平台在火山的战略定位有没有发生变化?

谭待:我觉得数据平台更重要了,因为模型能够降低使用门槛,更多人可以更容易地消费数据,生产和理解数据也更容易,对于数据平台来说重要性不言而喻。就像改良式的蒸汽机,对于下游的原材料价值更高。

问:相比数据分析的数据飞轮,大模型厂商的数据飞轮很难建立。客户都很看重数据资产,但是不愿意把数据拿出来给模型厂商,怎么看大模型公司自己的数据飞轮难以建立的问题?

谭待:比如说 A 公司用了大模型,但是全部都封闭在自己的体系,A 公司自己的数据飞轮是建起来了,对他是一个好事,但是大模型公司怎么搞?最近 OpenAI 的 CEO 也有一个澄清,GPT 有没有用用户的数据。本身新的技术安全合规,信任是很重要的,肯定要在这个规范下做事情。

在实际中,有些用户不愿意那么用,那就肯定不能用。但还有很多企业发现,用标准的东西不能完全解决我的问题,需要和底层的合作方(模型厂商)一起做优化,一起做优化的过程中自然而然就可以提升,数据飞轮就可以转起来。

所以第一要合规,第二,在实际生活中有些人因为需求驱动导致很多企业愿意和模型方共建,这种共建可以帮助双方的数据飞轮都建立起来。

问:如何把用户反馈的数据返回基础模型,有什么方法论吗?

谭待:这个难点就是企业和用户愿不愿意给第三方。(尽管)技术上也有一些难点,但是最大的难点是在意愿上。

问:MaaS 平台推出几个月了,也有自己的大模型,现在客户选择上选择最多的是哪一款?

谭待:我觉得比较分散,不同的场景同时考虑效果、性价比,有的还有私有化部署的需求,不同模型在这方面的表现不一样。

第二,相比全球最高水平,中国几个基础模型都有一定距离,现在大家更多还是在 POC(Proof of Concept,概念验证,被视为发布功能性产品的第一步)、在做测试。真正有比较好的 AI 原生的应用出来的话,可能还是要等到底座模型本身至少具备 GPT3.5+以上水平,我觉得到年底这个事情才会更加清晰一些。

谭待介绍大模型时代数据飞轮的新趋势|拍摄:极客公园

问:火山提到要全链路拥抱AI,具体如何系统布局,重点是什么?

谭待:确实大模型本身能应用的范式比较广泛,比如创作、内容、开发都有。其中数据分析是里面非常重要的一个环节,所以我们今天主要是讲我们数据分析产品上大概通过 AI 提供了哪些新的能力。其他的产品,我们在未来其他火山会议上也会逐步对外披露。

问:目前像字节内部对于大模型和AI业务资源倾斜的程度怎么样?在内部的权重如何?如何跟核心产品——抖音深度融合?

谭待:这次主要介绍的是数据产品的变化,大模型可以在 toB、toC 都有很大变化,你怎么找到这个方向,哪些优化是有价值的,还是要回到数据驱动上。这也是我们在这个阶段包括未来,数据产品很重要的原因,但是会通过模型本身让数据产品使用门槛更低,能创造更多价值。

C 端的产品陆续可以看到一些变化,但是跟火山关系不会特别大。

问:现在大模型普遍有一个问题是对齐不太好,经常会有幻觉,给人误导。火山有什么比较独到的经验和方案?比如,AB 测试和数据方面,你们有没有用这些方法来校准AI大模型?

罗旋:这确实是今天模型应用上一个非常大的阻塞点,在数据领域这个点尤其突出,因为数据本身是要求精确的东西,不是一个主观化的文本描述,不能是一个不精确或者错误的。

今天这个问题,整个行业都没有彻底解决,但有一些方法能够帮助我们一定程度上解决或者缓解这个问题。比如我们可以尝试让 AI 把它的思维过程、分析过程展示出来,一步步到底怎么推理、怎么想的。这个展示过程,人是可以看到的,当它出现错误时,我们是有可能发现这个错误的。

如果我们通过一些产品化的方式,能够让可能出现的错误比较显性地呈现在用户面前,让他轻易改动之后就能拿到正确结果的话,这很大程度上还是可用的,这是我目前觉得最重要的思路。

另一方面模型能力本身的提升也会很大程度上缓解这个问题,以 OpenAI 为例,GPT-4 比 GPT-3.5 有巨大提升,所以我们期待随着模型能力的进一步提升也可以变好。

还有一个思路,可以在模型上做一些领域的精调,在通用能力基础上加一些领域的知识,这也有利于帮助我们在具体的领域里面,让这个幻觉变得更小,准确率更高。这些方法结合起来,很大程度上这个产品能力跃过一个门槛是真的可用的。

谭待:AB 测试确实很重要,AIGC 的东西也不是唯一的答案,你怎么看(不同答案的)好坏,就像推荐一样,AB 测试是非常重要的。我们现在看模型,你去评估各种榜单,可能意义不是那么大,因为模型太大了,它可以把很多题目记下来,最终比较有用的还是通过 AB 测试来看,效果可能会比较好。