从囤 Web3「矿卡」,到囤 AI 算力卡,CoreWeave「赌运」亨通。

作者|芯芯

编辑|靖宇

制约 AI 人工智能发展最大的桎梏是什么?如在几年前,这个答案可能五花八门。但在大模型盛行的当下,这个问题只有一个答案——算力不够!

或者,换句话说,英伟达专用的 AI 算力芯片不够。

谁控制了英伟达的 AI 芯片,谁就控制了 AI 的未来。

现在,有这么一家公司,手中掌握了成千上万块英伟达的 AI「算卡」,客户涵盖了 OpenAI、微软等众多 AI 巨头。

作为「AI 算力黄牛」,这家名为 CoreWeave 的公司,在 4 年时间就将公司估值做到了 80 亿美元。拿到英伟达的独家投资之外,CoreWeave 还以手中的英伟达芯片做抵押,从黑石 Blackstone、Coatue 等顶级机构获得了 23 亿美元的债务融资。

没什么能阻挡 CoreWeave 的疯狂扩张,它到底是怎么搞定英伟达、从一家加密币「挖矿」公司,摇身一变成为 AI「算力基建」巨头的?

从「矿卡」到「算卡」

CoreWeave 的初创团队由三人组成,分别是 Michael Intrator,Brian Venturo 和 Brannin McBee,三人最初在金融领域工作,经营过对冲基金、家族办公室。

当年他们还在纽约管理基金时,加密货币挖矿热潮还未消退,最初只是为了赚取额外收入,他们购买了第一块 GPU,随后越买越多,华尔街的办公桌上堆满了 GPU。

「2016 年,我们购买了我们的第一块 GPU,插上电源,将其放在了俯瞰东河的曼哈顿下城办公室的台球桌上,然后挖掘了以太坊网络上的第一个区块。」CoreWeave 首席执行官 Michael Intrator,在一篇 2021 年的博客文章中如此回忆道。

很快,在 2017 年,他们将副业正式变成了一家公司,公司名字最初与加密货币相关,后来才改名叫 CoreWeave。在选择告别华尔街时,如同硅谷大佬都喜欢在车库里创业那样,他们将 GPU 硬件搬进了一个车库,不过这个车库不在西海岸的硅谷,而是在东海岸的新泽西郊区,属于其中一名创始人的祖父。

在过去十年中,GPU 是加密货币、人工智能技术热潮的重要引擎。在 2018 年底,CoreWeave成为北美最大的以太坊矿工之一,手握超过五万块 GPU,占以太坊网络的 1% 以上。

期间,几人也开始了解到其他公司对 GPU 资源的渴求。他们同时认识到,在加密货币领域并无持久竞争优势,因为市场竞争激烈,受电力价格影响大。

当 2018 年和 2019 年加密货币价格暴跌时,他们决定多元化经营,进入其他领域,这些领域比较稳定,但也需要大量 GPU 计算。他们关注人工智能、媒体娱乐和生命科学三大领域,并从 2019 年起,专注于购买企业级 GPU 芯片组,构建专门的云基础设施,围绕英伟达的芯片调整业务。

随着新业务步入正轨,以太坊挖矿业务渐渐边缘化。转型的决定证明是正确且幸运的,几个创始人都没有料想到即将到来的 AI 浪潮之热,让 CoreWeave 逐渐从一个小办公室扩张成遍布全国的数据中心,以对应不断膨胀的 AI 市场需求。

据其中一名创始人披露,2022 年,CoreWeave 收入约有 3 千万美元,预计 2023 年将超过 5 亿美元,增长超 10 倍,并且已经签署了近 20 亿美元的合同。今年宣布在德州投资 16 亿美元建数据中心,并计划在年底前扩展至 14 个数据中心。

AI 「电网」

在 CoreWeave 成立短短几年后,用于 AI 的 GPU 成为了全球最宝贵的资产之一,就像伊隆·马斯克等人调侃的,现在,购买 GPU 比买药还难。随着生成式 AI 点燃市场,对 GPU 的需求急剧增加,而 CoreWeave 正好位于为 AI 公司提供所需资源的有利位置。

作为一家云服务提供商,CoreWeave 提供高性能计算资源的租赁服务,主要面向需要大量算力的客户,模式是基础设施即服务,按小时出租 GPU,客户只需要按使用时间和计算资源量来支付费用,大客户还有定制设施,旗号是「比传统云提供商快 35 倍,成本低 80%,延迟低 50%」。该公司专注于高性能计算服务,而不像一般云服务商还提供存储、网络等多种服务。

去年,就在 Stable Diffusion 和 Midjourney 等发布之际,CoreWeave 的高管们购买了大量英伟达最新的芯片。后来见到 ChatGPT 发布,他们意识到这样的投资远远不够,这些人需要的 GPU 不仅仅是数千个,而是数百万个。

他们将 CoreWeave 要做的事情形容为「为 AI 市场建立电力网络」,并认为「如果这些东西不建成,那么 AI 将无法扩展」。

CoreWeave 的首席战略官 Brannin McBee 在一档播客中谈到,去年底,所有超大规模计算公司加在一起,包括亚马逊、谷歌、微软、甲骨文,将 CoreWeave 也算进去,它们共计提供了大约 50 万个 GPU,到今年年底,或许将接近 100 万个。

在行业增长速度和利润空间方面,他认为,AI 市场的需求可以拆解为训练模型和执行推理任务两个阶段,目前训练阶段存在芯片供应短缺,而推理阶段将是未来需求的主要增长点,也是真正的需求所在。

对于一家 AI 公司的一个模型而言,退出训练阶段后,在产品上市的前两年内,商业化阶段的推理执行至少需要百万个 GPU,但全球 AI 基础设施还不足以满足这一需求,这将是一个长期的挑战,至少需要再过两年,GPU 供应短缺才可能开始缓解。

如今,投入 AI 领域的热钱大部分都得用于云计算。今年 6 月,CNBC 曾报道称微软「已同意在未来多年内在初创公司 CoreWeave 的云计算基础设施上可能花费数十亿美元」。像 Inflection AI 这样的明星 AI 初创公司,最近筹集了 13 亿美元资金来建立大规模 GPU 集群,同时,该公司的选择也是 CoreWeave。

抱紧英伟达大腿

今年 4 月,CoreWeave 完成 2.21 亿美元 B 轮融资,投资者包含芯片制造商英伟达,以及前 GitHub CEO Nat Friedman 和前苹果高管 Daniel Gross。一个月后,公司宣布获得 2 亿美元加投,该轮融资总额达到 4.21 亿美元。

8 月,CoreWeave 又通过将高度抢手的英伟达 H100 作为抵押品,获得了另外 23 亿美元的债务融资,资金将用于收购更多芯片,以及建设更多数据中心。

根据彭博最新消息,CoreWeave 目前正准备出售 10% 股权,其公司估值最高已经达到 80 亿美元。

英伟达创始人黄仁勋今年在公司业绩电话会议上称:「你会看到一大批新的 GPU 专业化云服务提供商」「其中一个著名的就是 CoreWeave,他们做得非常出色。」

CoreWeave 与英伟达的联系在 2020 年已经开始,该公司当年宣布加入英伟达合作伙伴网络的云服务提供商计划,主要目的是将 GPU 加速引入云中。在不久前的 2023 年 Siggraph 计算机图形大会上,黄仁勋现身,CoreWeave 的每个展台都特意用小字标明「由英伟达提供动力」。

包括黄仁勋在内,英伟达的高管们不吝于给 CoreWeave 刷脸背书。

英伟达全球业务发展、云和战略合作伙伴全球总监称 CoreWeave 是「英伟达合作伙伴网络中的首个精英计算云解决方案提供商。他们为客户提供了广泛的计算选项,从 A100 到 A40,以前所未有的规模,以及在人工智能、机器学习、视觉效果等方面提供世界一流的结果。英伟达为 CoreWeave 感到自豪。」英伟达另一名高管则在融资声明中将其定位为「性能最高、能源效率最高的计算平台」。

这类赞誉也与英伟达自身利益相关。英伟达需要确保他们的计算终端用户能够以最高性能的方式,规模化地访问他们的计算资源,就像新一代芯片发布后,客户希望尽快获得它们一样。这也使他们不吝于宣传与 CoreWeave 的合作,多发展一个忠诚的「下线」并没有害处。

CoreWeave 正是在满足英伟达的标准和要求方面进行建设,规模化运营,在新一代芯片发布后的几个月内将其上线,而不是像传统的超大规模计算公司可能需要数个季度的时间。这使 CoreWeave 在英伟达内部具有较高的访问权限。

Brannin McBee 称「作为一家企业,这使我们在英伟达眼中赢得了信任,因为他们知道我们的基础设施将比市场上任何其他公司更快地交付给客户,而且以最高性能的配置交付。」

硬刚硅谷巨头

然而,面对硅谷巨头的竞争时,CoreWeave 如何自处?

从整个行业来看,CoreWeave 在 AI 基础设施运营方面的竞争对手包括微软、谷歌和亚马逊等科技巨头。

8 月底,谷歌云首席执行官 Thomas Kurian 在年度 Next 大会上称,目前行业中超 50% 的 AI 初创公司,以及超过 70% 的生成式 AI 独角兽都是谷歌云的客户。

一个八十亿美元估值的初创公司,如何避免被一堆万亿级别美元的巨头碾压?当下的答案在于:小公司自身的灵活性和业务聚焦,以及科技公司之间敏感的战略格局。

CoreWeave 高管们喜欢打一个比方:「通用汽车可以制造电动汽车,但这并不意味着它成为了特斯拉。」他们认为,人工智能提出了传统云平台无法处理的挑战,让新兴公司在被迫适应的老牌公司面前占据优势。

硅谷巨头们如亚马逊、谷歌、微软宛如同航空母舰,每次调整方向时都需要更多时间空间。在其看来,他们需要时间来适应新的 AI 基础设施构建方式,通常在最新芯片发布后需要一段时间才能提供规模化的访问。现在人们更加关注构建超级计算机,需要在这些计算机之间进行高度协同的任务,数据吞吐量更高,而巨头们最主要的资源并非用在这里。

「当这三家巨头建立云服务时,他们是为了其用户群中的数十万,甚至数百万所谓的通用用例提供服务,在这些区域中,里面可能只有一小部分容量用于 GPU 计算。」CoreWeave 首席技术官 Brian Venturo 称。

CoreWeave 自认其灵活性和专业性使其能够在 AI 基础设施领域脱颖而出,在性能和成本效益方面具有竞争优势,更适用于 AI 应用。CoreWeave 的员工只有两百多人,客户的数量都比员工多,但他们与 Inflection AI 甚至 OpenAI 支持者微软达成了协议,提供定制系统和更多配置的芯片,比为通用计算而配备的服务器更高效。

目前在规模方面,CoreWeave 称拥有超过 45000 个高端英伟达 GPU,可按需使用。重要的不仅仅是数量,而在于提供的访问权限。在选择方面,CoreWeave 声称保持行业内最广泛的英伟达 GPU 选择,以满足各种计算需求。他们设计了「合适大小」的工作负载系统,声称「既不多,也不少:刚刚好」。

至于价格,CoreWeave 的旗号是「比竞争对手便宜 80%」。

另一方面,背后英伟达的决策也很关键。通过掌控稀缺的 GPU 资源,选择提货给谁,也会影响整个市场。尽管供应紧张,但英伟达为 CoreWeave 分配了大批最新的 AI 芯片,从包括 AWS 等顶级云服务提供商那里分流供应。原因在于,这些公司正竭力自行研发 AI 芯片,以减少对英伟达的依赖。

CoreWeave 的高管持有这么一个观点:「不自己制造芯片绝对不是劣势」,因为这有助于他们争取从英伟达那里获得更多 GPU。毕竟,他们与英伟达不存在利益冲突,而胃口庞大的硅谷巨头们可能就不是这样了。

不过,科技巨头毕竟还是英伟达的大客户。今年 8 月底,黄仁勋现身谷歌云年度 Next 大会,宣布与谷歌的新合作,谷歌的 GPU 超级计算机 A3 VM 在 9 月将向市场推出,搭载的是英伟达的 H100 GPU。

谷歌云 Next2023 大会上,黄仁勋现身宣布和谷歌云的合作|Google Cloud

另外,如果真的突然出现了一种新的芯片,性能可以比英伟达更好,或不逊色于它,那将给 CoreWeave 的业务产生什么影响?

Brannin McBee 认为,同一芯片的寿命包括前两到三年用于模型训练,然后四到五年用于推理执行,短期内风险不大。而且,英伟达正努力建立硬件周围的开放生态系统,以增加行业对其芯片技术的黏性,其他制造商显然非常有动力进入这个领域,但他们缺乏生态系统,这是一个不可忽视的鸿沟。

在没有硬核的芯片制造技术的情况下,CoreWeave 的相对优势和成功,牢牢系于其合作伙伴的供应链和稳定性,在全行业 GPU 紧俏的时候,这种依赖就还是优势。

从加密币「矿场」到人工智能「算力矿场」,CoreWeave 的发迹史令人咋舌——时代的一粒金沙,即便落到一个创业公司身上,也能让其迅速崛起。在这个 AI 狂飙的时代,行业对于算力的渴望,成就了万亿美元的英伟达,显然也成就了 CoreWeave 这样能瞅准时机 All in 的公司。

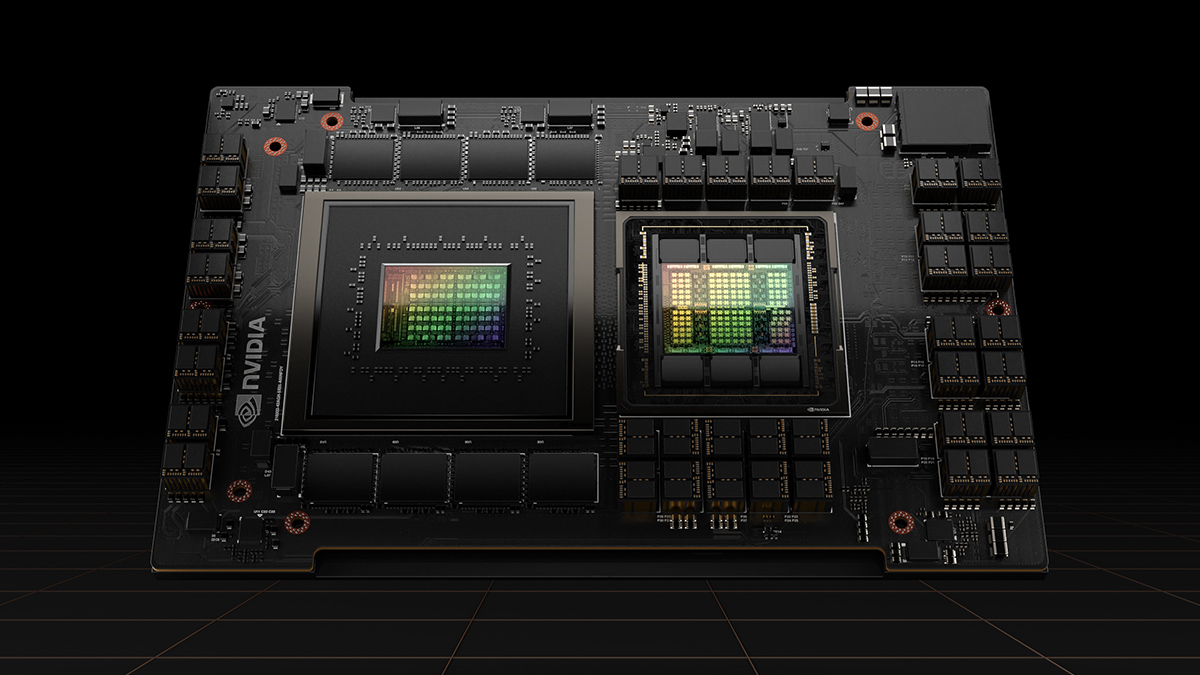

头图来源:Nvidia