飞桨与文心一言在训练和推理的联合优化协同

4 月 23 日消息,一份百度文心一言内部会议纪要流出。从纪要内容看,文心一言启动邀测后一个多月内,用户同时在线数增长对响应速度提出了挑战,尤其对框架层和模型层——飞桨与文心一言在训练和推理的联合优化协同方面,提出了更高要求。

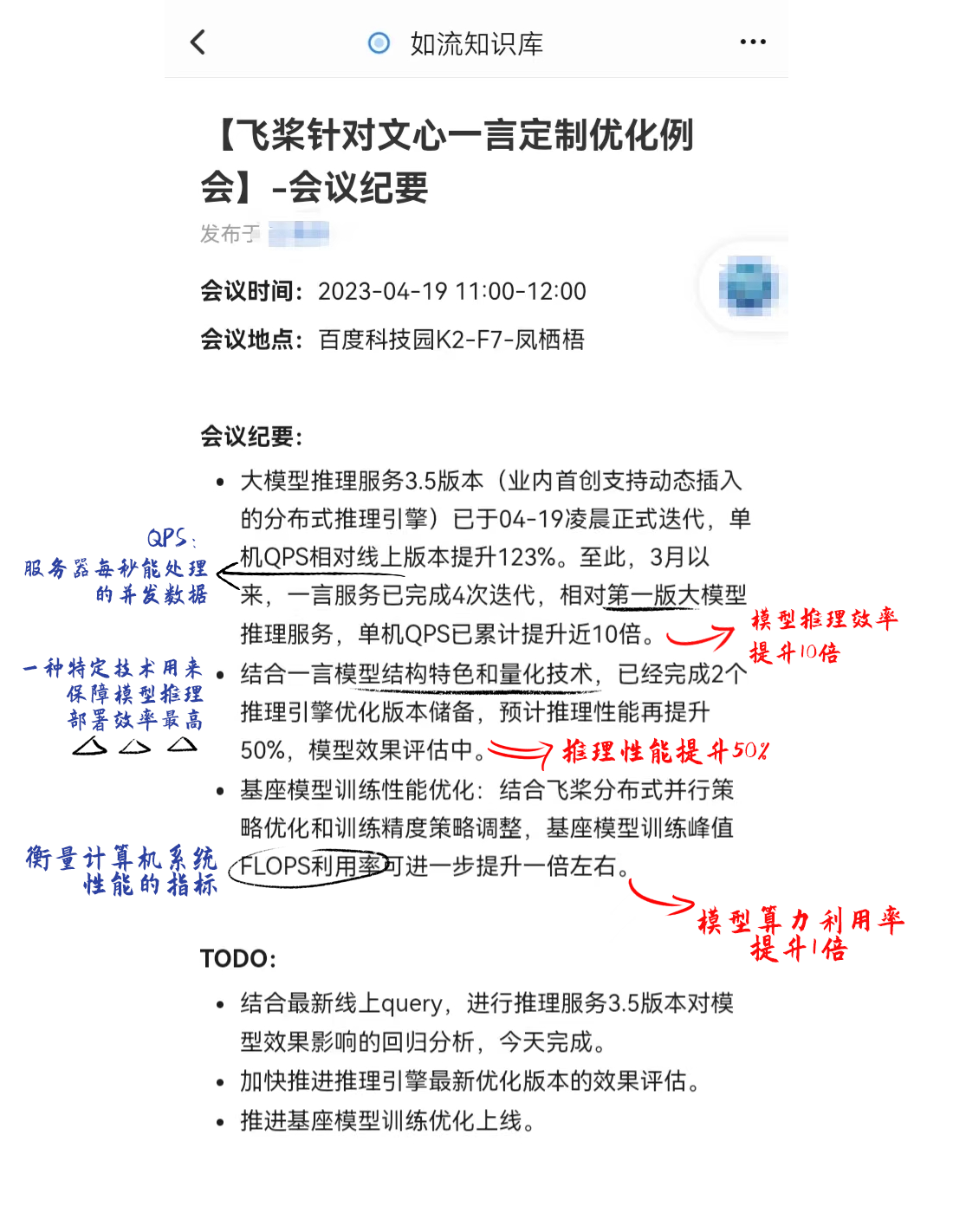

一个月的成绩单:

三个数字反应了百度应对企业客户的响应状态:

· QPS 已累计提升近 10 倍

目前国内各大公司大模型中,文心一言于 3 月 16 日最早启动邀测。飞桨在文心一言开启邀测后,一个月内迭代了 4 次,其支持大模型推理服务于 4 月 19 日再次迭代,3.5 版本于 4 月 19 日凌晨正式迭代。

据悉,其首创支持动态插入的分布式推理引擎,使得单机 QPS(服务器每秒能处理的并发数据)或者说推理效率相对线上版本提升 123%;相对第一版大模型推理服务,单机 QPS 已累计提升近 10 倍。换句话说,模型推理效率提升 10 倍,意味着成本降低为原来 1/10,或意味着可为 10 倍数量用户提供服务。

对于 QPS(每秒查询推理响应速度)提升 10 倍,有分析人士解读认为,「大模型就仿佛汽车的发动机,光账面上的动力强,参数大是没有用的,要压榨出发动机瞬时最大爆发力(QPS)以及最优的性能表现。深度学习框架就像是生产发动机和变速箱的,可以让发动机整体部件组合更精密、动力更强。自研产品彼此适配度更高,协同会更高效,这可能是效率提升的最根本原因。」

· 推理性能或再提升 50%

除了 QPS 的提升,纪要显示,结合文心一言模型结构特色和量化技术(用以保障模型推理部署效率最高),飞桨已经完成 2 个推理引擎优化版本储备,预计推理性能再提升 50%,具体模型效果还在评估中。

模型推理性能提升 50%,表明飞桨助力文心一言快速学习。

其实,除了算力和数据,深度学习框架对大模型的训练和推理也同样重要,这也是百度在这轮大语言模型的一大优势。飞桨之于文心一言,不仅是在于安全合规,更在于灵活可控。

相比国内很多厂商使用谷歌的 TensorFlow、Facebook 的 PyTorch 等深度学习框架,百度自研的开源深度学习框架飞桨可以最快地基于国内大模型做出反应。由于深度学习框架具有赢家通吃的特性,深度学习框架规则的制定具有排他性,人工智能在深层领域的通用技术将受到框架规则的限制。而只有结合深度学习框架去设计、优化、迭代,人工智能硬件、软件的开发才能发挥出最大效力,在这一点上,百度早在 2016 年就做出相应布局。

· 模型算力利用率可提升 1 倍

第三个数据体现在基座模型算力的利用率上,根据这份纪要,结合飞桨分布式并行策略优化和训练精度策略调整,基座模型训练峰值 FLOPS 利用率(衡量计算机系统性能的指标)可进一步提升一倍左右。

模型算力利用率提升 1 倍,是基于四层架构端到端训练的优势,飞桨深度学习框架向下与芯片、向上与模型协同优化。

2022 年 12 月以来,微软作为 OpenAI 的独家云计算供应商,赢得了更大的市场份额。据 The information,目前,微软云的客户需要排队数月才可以获得云计算资源。这是因为微软基于大模型来设计它自身云的产品体系,使其能够把算力、大数据、机器学习等能力发挥到极致。

训练 GPT-4 这样的大语言模型,需要依赖强大的算力,因此,微软在几年前就基于 GPT 大模型的特性,对微软云等 AI 技术底座进行了调整,使其适配大模型训练和推理对于高算力和特殊架构等的需求。

就国内而言,百度已经做 AI 十年了,是国内少有的全栈公司,同时具备人工智能的四层能力,包括芯片层的昆仑 AI 芯片、框架层的飞桨深度学习框架、模型层的文心大模型和应用层的搜索、自动驾驶、智能家居等场景。自建 AI 各层能力,可以更高效地优化每一层能力。

「反馈驱动创新」,让大模型平民化

在百度内部,李彦宏推崇「反馈驱动创新」,基于客户做快速验证与迭代。从 3 月 16 日到 4 月 19 日,这份流出的「飞桨针对文心一言定制优化例会」显示的三个数字——10 倍,50%,1 倍背后,飞桨在快速迭代。

通过与行业客户共创,围绕着大模型去重新构建、提升一系列 AI 产品和体验,从而进一步降低大模型的使用门槛和落地成本,提升训练与推理效率。这利好大模型迅速走向产业化。

一如当年在「要不要上公有云」的问题上,早期国内 B 端生态也无法达成一致。但现在,上云成为了绝对主流趋势,其背后是亚马逊云 AWS 从 2010 年到 2020 年降了 70 次价,前几年是每个月降一次价。亚马逊有底气如此降价背后,是其对整个云的基础设施、中间层,投入了巨大的研发。

AI 大模型也是这样,要训练一个有常识、有人类 AGI 能力的一个大模型,并不是很多厂商都能干的事情。百度能把大模型做好,文心一言在 COT(Chain of Thought,逻辑链)、ITL(In-Text Learning,上下文学习)等能力涌现、知识增强方面表现出众。同时,百度正在像上一个时代——云计算时代的亚马逊一样,通过技术架构的快速迭代,使得做 AI 推理、生产的成本非常非常低,甚至以后无限地逼近于人脑的功耗水平。这上面需要巨大的投入,是要百亿美金、甚至几百亿美金的投入在里面。

百度的快速迭代也反应了其在大模型时代的愿景,正如李彦宏对飞桨的定位,「飞桨就是人工智能时代的操作系统,让开发者能够像搭积木一样构建 AI 应用,大大降低 AI 的应用门槛。」