手机厂商们得到了启发:既然硬件不可能获取媲美专业相机的照片,那缺失的那部分能不能让 AI「猜」,让算法「补」?

10 年前,Instagram 之所以能爆火,原因之一是当时手机镜头太差,而滤镜用美化掩盖了前者的「无能」。10 年后,今非昔比。手机上的镜头越来越多,摄像模组越来越厚,传感器甚至飙升至一亿像素……但近几年,手机厂商没在「堆料」路上继续狂奔。随着手机空间和芯片工艺的限制,像素和传感器尺寸的增速都在放缓。

但实际上,「摄像头军备竞赛」并没有停止,厂商只是换了条赛道奔跑。

自 2019 年起,「计算摄影」的概念在手机上兴起。在手机这种力求便携的设备上,镜头不可能做得太大,厂商干脆换了方向:既然从根上无法突破光学的物理限制,那就从「软」入手,通过 AI 干预来改善摄影。简单来说,就是原来硬件看不到的,AI 来告诉它都有什么。甚至,计算摄影在某些方面已经超越了传统相机,它不只是为了接近后者。

拍照不止于硬件

最具代表性的是三年前的 Google Pixel 3,仅凭单摄就在变焦、夜景、虚化等功能上「吊打」友商。

这都让用户开始意识到,「堆料」不一定能满足拍摄需求。在一部不只单纯为拍摄服务,且存储空间有限的手机上,用户是想拍出一张达到 1 亿像素的照片吗?相比「足够大」,他们更需要的是「足够好」——稳定,均衡,易用,能够激发创作欲。

手机不是传统镜头,它的芯片处理能力是持续进化着的。这给了手机厂商们启发:既然硬件不可能获取媲美专业相机的照片,那缺失的那部分能不能让 AI「猜」,让算法「补」?

那么,AI 在哪些方面改变了传统的手机摄影?

先以「超分辨率」为例,所谓的超分辨率,就是从一个低分辨率照片,变成了一个高分辨率照片,AI 靠「猜想」补充上了低分辨率照片没有的细节。AI 是怎么拥有这种能力的?简单来说,先拿出一张高分照片 A,然后故意「丢失」一些细节得到低分照片,继而把它等比放大一张高分照片,接着进行一系列的特征提取得到一张有充分细节的高分照片 B,再将 B 和 A 比对,如果二者接近,则说明中间的参数调对了,这样就把 AI 训练好了。

手机能够进行大范围的变焦,就归功于超分辨率。图片放大后,噪声和抖动会非常大,有了这个功能,就能通过 AI 推理修正噪声和抖动,让图片看起来更清楚。

再说说夜景模式,用户在夜晚拍照时,往往光线不足,噪声明显。这时如果想要进光量充足,就需要长曝光,但长曝光抖动造成的模糊就很明显。曝光时间如果不够,画面就会很昏暗,如果画面有高亮度的灯,长曝光时灯就会过曝,总之,相机很难把明暗处都看得清楚。

传统的解决方案是,用户把设备先固定好,拍一张长曝光,另外再拍短曝光,最后进行后期,将相片手动合成为一张,耗时费力。而现在手机上的 AI,可以先进行智能降噪,然后自动拍摄数张长短曝光照片,自动合成,而且这一系列动作都在用户按下快门的短瞬之间就完成了。就这样,用户最终得到了一张 HDR(高动态范围)的照片。

AI 又是如何帮助照片呈现自然虚化的呢?双摄就相当于是人的两只眼睛,每只眼看同一物体的角度不同,会有视差,这种差异能推断出物体之间的前后关系。如果物体离得较远,这种方法就不奏效,加上长期开启多个摄像头功耗增大,业界开始引入 AI。厂商拿大量的图片素材投喂 AI,进行训练,AI 之后就能通过一张 2D 照片,区分谁在前谁在后。通过这种方法,还可以实现人像和背景的精准分割,比如常见的「魔法换天」功能就是对其中的背景进行处理。

使用「魔法换天」,用户可以任意改变照片中天空的状态,尽管原图是白天的云层,但当用户选择「星辰」效果时,照片就会呈现出夜晚中的漫天星空。在强大 AI 引擎下,前后景的分离与融合,天际线的地方几乎看不到后期处理的痕迹。

还有诸如 AI 防抖、旧照片修复、路人消除等功能,都靠手机上的算法驱动。前几年,厂商们拼的是镜头数量;未来,他们要拼 AI 和算法。AI 在智能手机渗透率不断提升,逐渐与手机拍摄融合。

做传统相机做不到的

艾瑞咨询发布的《2020 中国人工智能手机白皮书》显示,2020 年上半年,短视频应用在消费者常用 app 的单机单日有效时长占比接近 32%。

此外,手机拍摄功能已成为中国消费者最关注的手机要素,这将继续引导手机厂商提升手机拍摄能力、拍摄功能与使用体验。《白皮书》指出,手机厂商拍摄算法与外部算法公司合作广泛,将近 60% 手机拍摄算法,通过与算法公司合作研发获得;「AI + 光感知」手机算法市场高度集中,以旷视为代表的头部企业份额占比接近 80%。

除了前文提到的超分辨率、夜景模式和虚化呈现,手机厂商还通过算法的方式,更好地协调和调度更丰富的镜头组,从而实现近似单反相机的拍照效果,如多摄虚化和平滑变焦等。

在变焦方面,我们知道 12-24 毫米适合拍大场景风光,24 毫米拍日常纪实,35-50 毫米拍人文,85-135 毫米拍人像等等。单一镜头很难满足这些需求,而同时加入广角、超广角、长焦镜头这些不同焦段的镜头,就能应对更加广泛的拍摄场景。

不过手机内部空间寸土寸金,手机摄像模组尺寸较小,还需要封装很多硬件和系统,所以很难有与单反相同的光学结构,因此目前手机上的镜头大部分都是定焦镜头,只能在特定变焦节点上实现真正的光学变焦。比如我们常见的 2 倍、3 倍、5 倍变焦,而在拍摄这些光学变焦节点之间焦段的画面时,就需要通过「裁切」来实现,同时画面还可能要跨越不同的镜头。

这时,要实现多枚不同焦段镜头之间更平滑的连续变焦,就需要算法的加入。通常来讲,比如在拍摄 1.5 倍变焦时,算法会将画面中心区域替换为更加清晰的 2 倍长焦拍摄画面,而四周则可以用 1 倍主摄的成像,将两者结合起来,实现双摄的融合。

后置摄像头不是越多越好,也不是越大越好。厂商们也开始转换思路,不再只是「如何让一枚镜头变得很强」,而是「如何让多枚镜头可以更好地协同起来」。

AI 多摄逐渐走进大众视野,既得益于手机厂商对于产品的迭代升级,也离不开旷视等 AI 企业对于底层技术的创新和赋能。以多摄融合为例,旷视的多摄融合算法采用神经网络设计模型,可有效解决清晰度不均匀、主体边缘线条弯曲、部分位置重影、线条断裂错位、重复纹理错位等传统多摄融合算法中的常见问题。

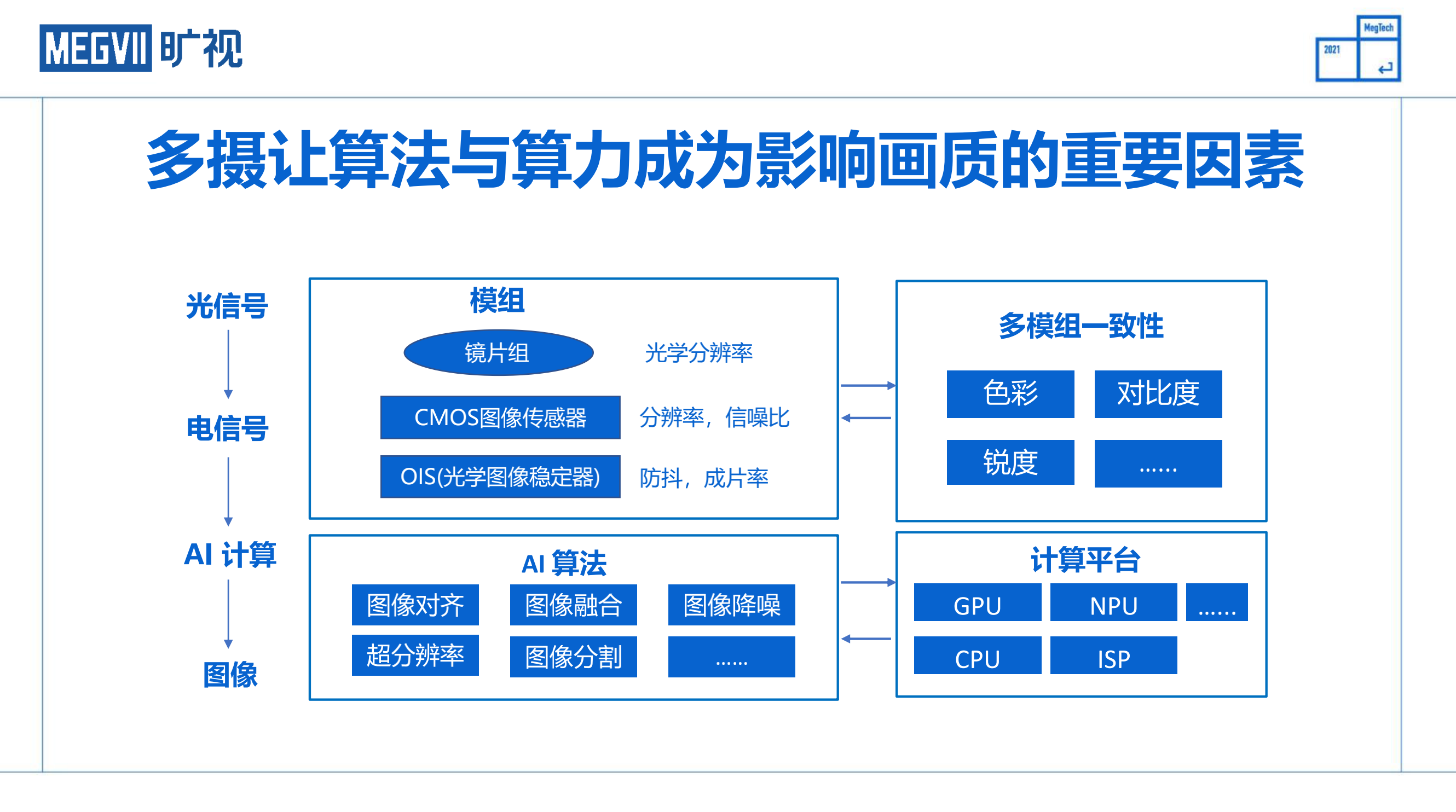

在旷视 10 月 12 日举办的漫谈 AI 技术分享会上,旷视研究院研究员范浩强介绍说,当下基于 AI 计算摄影的手机拍照已经是光、电、算一体化的过程了,涉及光信号、电信号、AI 计算等多个环节。现在 AI 算法的领域变得越来越大,手机算力本身也在不停增加,按照这样的趋势发展,也许将来手机里面所有的算法都可以使用 AI 了。」

手机成像是一套系统工程,考验的是各个要素之间的匹配。旷视认为,之前的光感知系统是「硬件升级——算法辅助——优化后期处理」相对独立化的运作,有了 AI 的加入,便能将这些流程和软硬件一起协同起来,完成升级。这也就是旷视率先提出的「AI 重新定义光感知系统」理念。

从整个影像系统出发,配合智能手机的光学系统以及传感系统,借力 AI 算法,通过图像识别、融合、增强、分割等方式,升级成像质量,在有限的硬件条件下带来指数级的效果提升。

范浩强说,「原来的算法对于弱纹理或者无纹理的地方计算很困难,一面白墙过来之后算法就蒙了,不知道到底哪个点该匹配哪个点。但是神奇的深度学习使得这一切都成为了可能,在茫茫一片白雪的场景里面,都可以算出准确的光流来。」

有了 AI 的协力,手机甚至做到了传统相机做不到的。

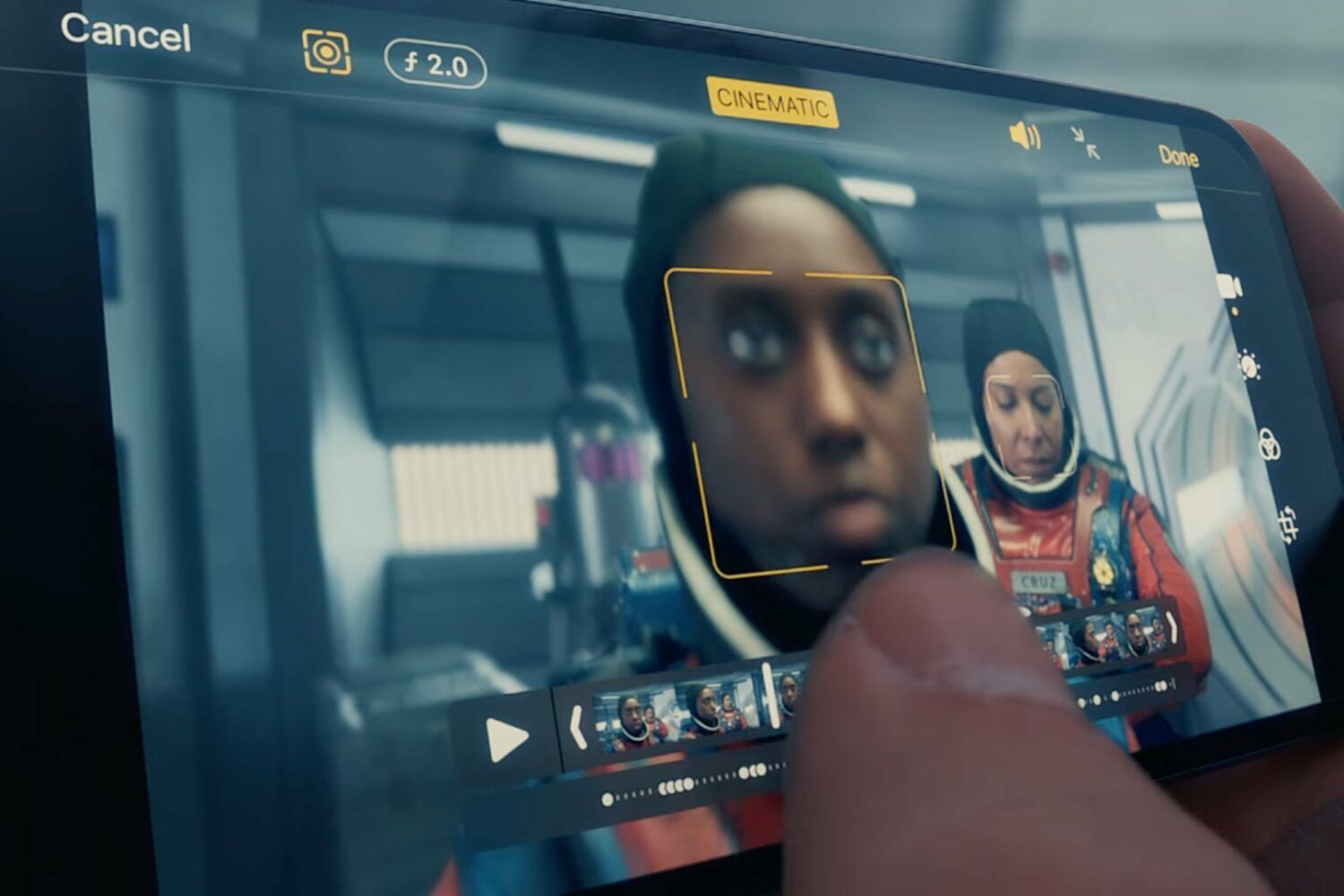

以 iPhone 13 上的「电影模式」为例,画面中的焦点会根据情节发生变化,引导观众的视觉,关注画面中的不同区域,要实现这样的效果,传统影视拍摄都需要一个摄影师和一个跟焦员默契配合,往往得拍个三五遍,但现在在计算摄影的辅助下,算法认出了画面中的人物,认出了人物的目光看向的方向,手机这时候知道应该怎么自动调节对焦参数。

更让吃惊的是,焦点还能在后期继续调整。这种自由度,是传统相机无法给予的。

「流行百科的说法是,计算摄影就是在拍摄的同时用计算机进行一定程度的计算修饰。美颜模式就是这个意思。但是我认为这个定义没有真正地说出计算摄影的精髓,它会让人大大低估计算摄影的强大能力……计算摄影就是让你的拍摄设备像摄影师一样理解你拍摄的对象是什么,它更应该叫智能摄影。」科普作家汪诘说道。

用强大算法创造全新的视觉想象

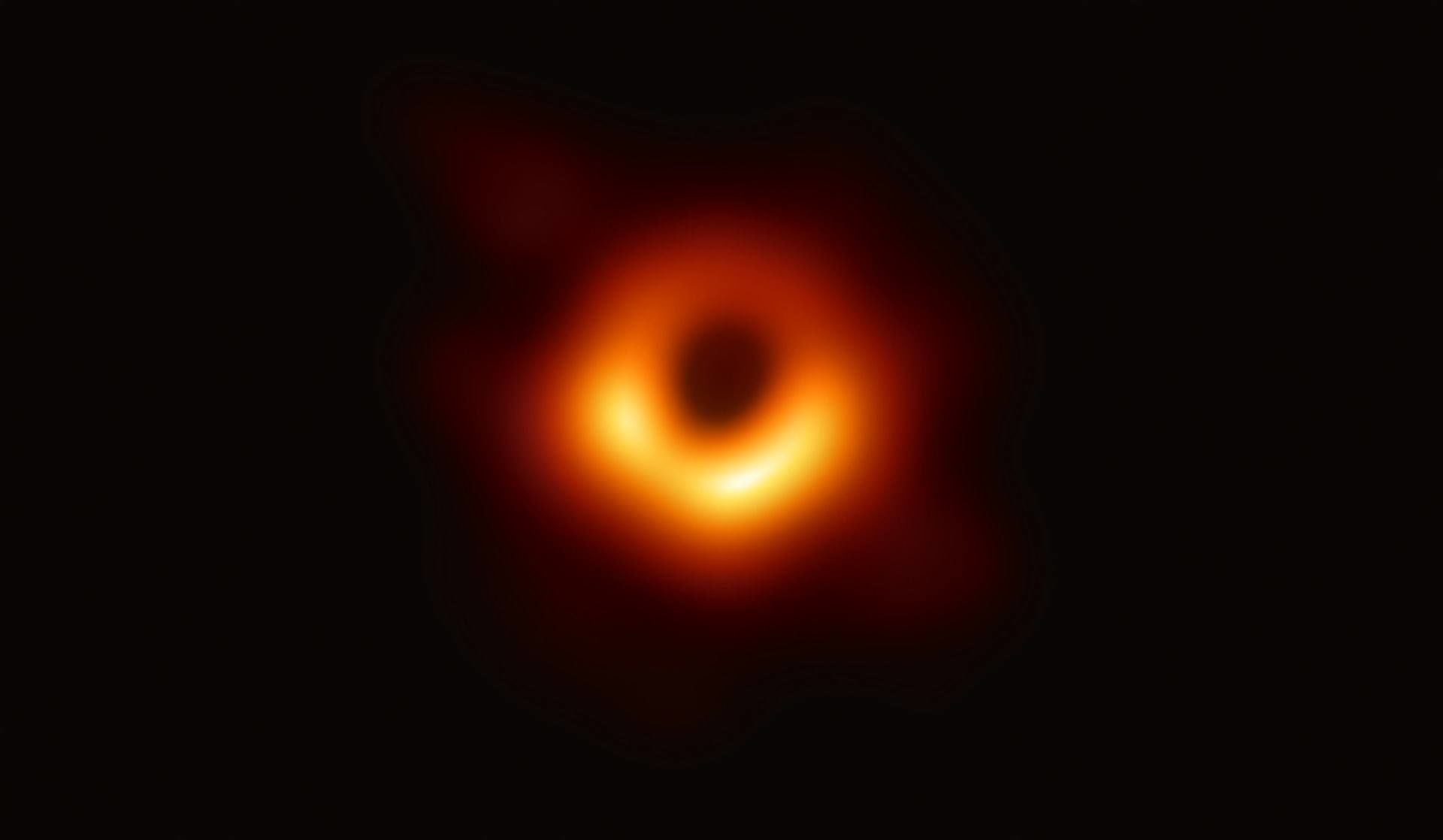

2019 年 4 月 10 日,全球多地天文学家同步公布首张黑洞真容,这是这是人类史上首张黑洞照片。这个明亮的火环让人振奋,有望证实爱因斯坦广义相对论在极端条件下仍然成立。但由于黑洞本身不发光,所以要拍出这张照片困难重重。

科研人员集合了分布在全球各地的 8 个高灵敏度射电望远镜,从智利阿塔卡马沙漠到南极冰原,从西班牙的高山到夏威夷的海岛,这 8 个射电望远镜通过「甚长基线干涉测量技术」联合起来,模拟出口径像地球一样大的望远镜。

收集完素材后,经大约两年的数据处理及理论分析,照片才成功「冲洗」出来。也就是说,黑洞的照片也属于「计算摄影」。「技术的突破、世界上最好的射电望远镜之间的合作、创新的算法都汇聚到一起,打开了一个了解黑洞的全新窗口。」项目主任谢泼德·杜勒曼说道。

计算摄影就是如此,用 AI 突破光学的物理限制,用强大的算力创造全新的视觉想象,用深度学习来超越人眼可见的细节。计算摄影技术的持续进化,会催生一些明星公司。同手机的物理升级相比,计算摄影是隐形的,而为计算摄影提供技术的 AI 公司更是隐形的。AI 多摄能逐渐走进大众视野,既得益于手机厂商对于产品的迭代升级,也离不开旷视等 AI 企业对于底层技术的创新和赋能。