「快速、充足的内存带宽和容量对实现高性能超级计算应用来说至关重要。」

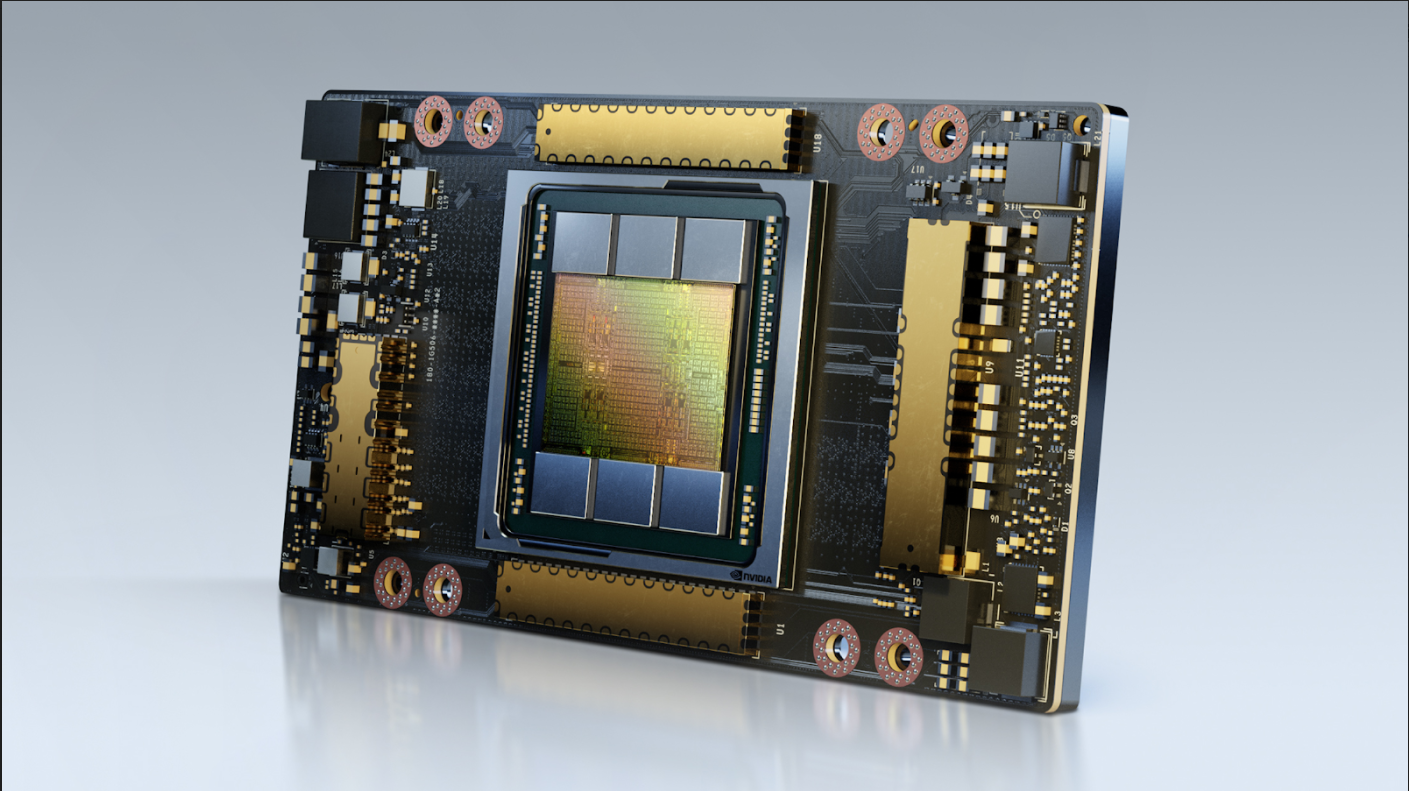

2020 年 11 月 16 日,今日英伟达发布 A100 80GB GPU,该产品支持英伟达 HGX AI 超级计算平台,且内存比上一代产品提升一倍,面向研究人员和工程师提供空间速度与性能,助力实现新一轮 AI 和科学技术突破。

据了解,全新 A100 采用 HBM2e 技术,可将 A100 40GB GPU 的高带宽内存增加一倍至 80GB,提供每秒超过 2TB 的内存带宽。这使得数据可以快速传输到全球最快的数据中心 GPU A100 上,使研究人员能够更快地加速其应用,处理最大规模的模型和数据集。

NVIDIA 应用深度学习研究副总裁 Bryan Catanzaro 表示:「若想获得 HPC 和 AI 的最新研究成果,则需要构建最大的模型,而这需要比以往更大的内存容量和更高的带宽。A100 80GB GPU 所提供的内存是六个月前推出的前代产品的两倍,突破了每秒 2TB 的限制,使研究人员可以应对全球科学及大数据方面最严峻的挑战。」

满足大流量数据工作负载需求

A100 80GB GPU|英伟达

A100 80GB 版本基于 A100 40GB 的多样化功能,成为需要大量数据存储空间的各类应用的理想选择。

DLRM 等推荐系统模型为 AI 训练提供了涵盖数十亿用户和产品信息的海量表单。A100 80GB 可实现高达 3 倍加速,使企业可以重新快速训练这些模型,从而提供更加精确的推荐。

HGX 服务器中搭载的 A100 80GB 还可训练具有更多参数的最大模型,如 GPT-2。GPT-2 是具有超常生成文本能力的自然语言处理模型。这就消除了对数据或模型并行架构的需求,因为实现并行架构需要花费大量时间,而且跨多个节点运行缓慢。

凭借其多实例 GPU(MIG)技术,A100 可分割为多达 7 个 GPU 实例,每个实例具有 10GB 内存。该技术是一种安全的硬件隔离方法,在处理各类较小的工作负载时,可实现 GPU 最佳利用率。对于如 RNN-T 等自动语言识别模型的 AI 推理,单个 A100 80GB MIG 实例可处理更大规模的批量数据,将生产中的推理吞吐量提高 1.25 倍。

在 TB 级零售大数据分析基准上,A100 80GB 将其性能提高了 2 倍,使其成为可对最大规模数据集进行快速分析的理想平台。随着数据的动态更新,企业可以实时做出关键决策。

对于科学应用,A100 80GB 可为天气预报和量子化学等领域提供巨大的加速。材料模拟软件 Quantum Espresso 采用单节点 A100 80GB 实现了近 2 倍的吞吐量提升。

RIKEN 计算科学中心负责人 Satoshi Matsuoka 表示:「快速、充足的内存带宽和容量对实现高性能超级计算应用来说至关重要。具有 80GB HBM2e GPU 内存的 NVIDIA A100 提供 2TB/s 的全球最快带宽,可帮助我们大幅提高应用性能。」

A100 80GB 具备 NVIDIA Ampere 架构突破性特性:

一、第三代 Tensor Core 核心:通过全新 TF32,将上一代 Volta 架构的 AI 吞吐量提高多达 20 倍。通过 FP64,将 HPC 性能提高多达 2.5 倍。通过 INT8,将 AI 推理性能提高多达 20 倍,并且支持 BF16 数据格式。

二、更大、更快的 HBM2e GPU 内存:使内存容量增加一倍,在业内率先实现 2TB/s 以上的内存带宽。

三、MIG 技术:将单个独立实例的内存增加一倍,可最多提供七个 MIG,每个实例具备 10GB 内存。

四、 结构化稀疏:将推理稀疏模型的速度提高 2 倍。

五、第三代 NVLink 和 NVSwitch,相较于上一代互连技术,可使 GPU 之间的带宽增加至原来的两倍,将数据密集型工作负载的 GPU 数据传输速度提高至每秒 600 gigabytes。

DGX Station A100|英伟达

此外,英伟达还发布了全球唯一千兆级工作组服务器英伟达 DGX Station A100,作为第二代 AI 系统,其性能可达 2.5 petaflops,是唯一亿台配备四个通过 NVLink 完全互连的全新 A100 Tensor Core GPU 工作组服务器,可提供 320GB GPU 内存。且是唯一支持多实例 GPU(MIG)技术的工作组服务器,借助于 MIG,单一 DGX Station A100 最多可提供 28 个独立 GPU 实例以运行并行任务,不影响系统性能前提下支持多用户。

DGX Station A100 无需配备数据中心级电源或散热系统,具备与 DGX A100 数据中心系统相同的远程管理功能,在 AI 训练方面,DGX Station A100 比上一代提速 4 倍以上,对于 BERT Large AI 训练等复杂模型,性能提高近 3 倍。

目前,宝马集团生产部、 德国人工智能研究中心(DFKI)、NTT Docomo、太平洋西北国家实验室(PNNL)等正基于 DGX Station 开发部署 AI 模型,或展开相关研究。

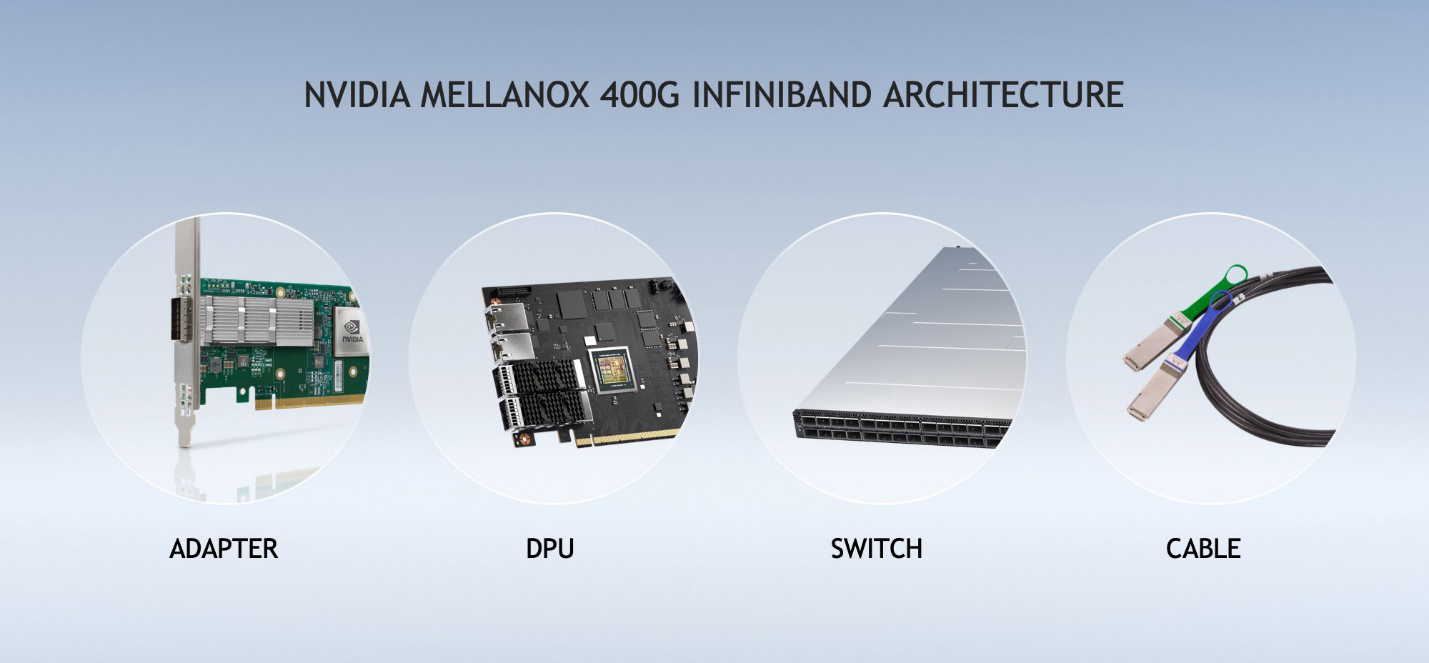

Mellanox 400G InfiniBand|英伟达

发布会最后,英伟达发布 Mellanox 400G InfiniBand,为人工智能开发人员和科研人员提供最快的网络性能。随着药物研发、气候研究和基因科学等领域对计算需求的指数级持续增长,NVIDIA Mellanox 400G InfiniBand 在通过提供全球唯一的完全硬件卸载和网络计算平台,实现了大幅的性能飞跃,可加快相关研究工作的进展。

第七代 Mellanox InfiniBand NDR 400Gb/s 产品提供超低延迟,并在上一代产品的基础上实现了数据吞吐量翻倍,同时增加了新的 NVIDIA 网络计算引擎,实现了额外的加速。NVIDIA Mellanox NDR 400G InfiniBand 提供 3 倍的交换机端口密度,使 AI 加速功率提高 32 倍。此外,它将交换机系统聚合双向吞吐量 5 倍,浪涌到 1.64 petabit/秒,使用户能够以更少的约束运行更大的工作负载。

英伟达加速计算高级总监 Paresh Kharya 告诉极客公园,「加速计算平台极为重要的工作平台,包括高性能科学计算、AI 人工智能、图像处理分析等等。从小尺寸 GPU到史上最高性能 GPU,我们提供了全系列的 GPU,这些产品都可以在云端使用,或者应用于超级计算中心。它们也可以被用于 AI 数据处理量工作负荷大的企业的数据中心。因此,我们新开辟的产品恰好是数据中心业务最重要的增长。」

在产品供货方面,英伟达 DGX Station A100 和 DGX A100 640GB 系统将于本季度通过英伟达全球合作伙伴网络经销商供货,其中,英伟达 DGX A100 320GB 用户可选择升级。

图片来源:英伟达