在 Gemini 的爆火之后,Google Cloud 正在成为真正意义上的「基础设施」。

北京时间 4 月 10 日凌晨,Google Cloud Next 2025 正式揭开序幕。

如果用「AI 届的苹果发布会」来形容每年的英伟达硬件发布会,那「AI 届的 CES」或许更适合用来形容今年的 Google Cloud Next;虽然同样令人兴奋,但每一个来到现场的人都带着自己的问题,现场随处可见各种务实的交流。

络绎不绝的观众前往 Google Cloud Next 25 主题演讲 | 图片来源:极客公园

三个月前,同样是拉斯维加斯,这个场馆这个舞台上,黄仁勋同样以 AI 为主题的演讲,揭开了 CES2025 的序幕。

但即使是老黄的主题演讲,都不及今天的 Google Cloud Next 开幕主题演讲座无虚席;即使场内已经人满为患,仍然有大量的人在门口排队,等待有空缺位置时第一时间入场。

主题演讲现场,人数甚至比老黄演讲更多 | 图片来源:极客公园

之所以没有老黄的个人魅力,Google 的动作仍然能被如此多的业界人士关注,显然是因为 Google 如今在 AI 模型应用部署领域的统治地位。有了 Gemini 2.5 Pro 的打底,Google 今年在 AI 领域的影响力已经处于第一梯队,但对于 Google Cloud 来讲,如何将这部分能力,转化给全世界的用户的实际使用中,才是这届 Next25 最需要给全球用户解答的问题。

不仅有针对推理模型优化的第一代 Google Tensor TPU 芯片,还有 Gemini 能力在 Google Workspace 生态中的进一步「植入」,甚至祭出了「本地部署 Gemini」这样的大招。以及让不少业内人士感到兴奋的「Agent2Agent」沟通协议。

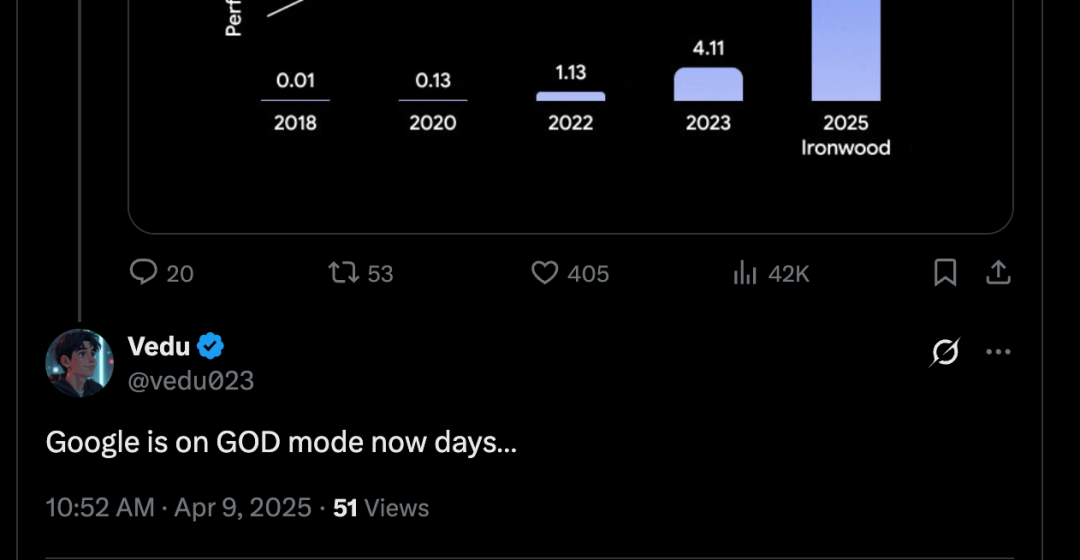

网友对 Google Cloud Next 发布产品的评价 | 来源:X

仅仅是首日的主题演讲,Google 就已经展现出几乎是在 AI 应用领域「全方位出击」的产品规划,并且在几乎每一个领域都拿出了业内最前沿的思考与解决方案。

难怪有不少网友,在看完 Google Cloud Next 25 的主题演讲全部内容后,直呼「Google 真的是目前大模型厂商中开启了「上帝模式」的选手」。

01

新模型

作为 Google CEO 皮查伊上台亲自发布的产品,Gemini 2.5 Flash 与它的前辈 Gemini 2.5 Pro 不同,这是一款「提供强大性能的同时注重效率」的推理模型。

Gemini 2.5 Flash 作为新模型发布 | 图片来源:极客公园

据皮查伊介绍,Gemini 2.5 Flash 主打卖点是提供「动态且可控的」计算能力,允许开发者根据查询的复杂性,手动调整处理时间。「你可以根据具体需求调整速度、准确性和成本之间的平衡。这种灵活性对于在高流量、成本敏感的应用中优化模型的性能至关重要」。

根据在现场与 Google 工程师的交谈,他指出 2.5 Pro 在处理一些简单的问题时,仍容易出现「过度思考」导致其响应速度大幅降低的问题。这也是 2.5 Flash 在体验中力求解决的难点。但最终他们的目标,还是进一步改善模型的动态思考能力,并将更多控制权开放给用户。

作为打响大模型性价比大战第一枪的选手,Google 还特别提到了与 DeepSeek R1 这样「价格较低但性能良好的模型」的对比,表示 2.5 Flash 非常适合在「高流量」和「实时」应用的商用场景——例如客户服务和文档解析。

除了新模型,Google 还放出了将最新模型「本地部署」这样的策略,来让已经有自己数据中心、或是有着更高数据管理要求的客户,能够使用现有的硬件设施,快速在自己的服务中部署 Gemini 2.5 Flash 的能力。

Google 计划从第三季度开始,将 2.5 Flash 这样的 Gemini 模型引入本地部署环境。该公司的 Gemini 模型将可在 Google Distributed Cloud (GDC) 上使用,同时表示 Google 也正在与英伟达合作,将 Gemini 模型引入符合 GDC 规范的 Nvidia Blackwell 系统。

这样的服务分量也吸引到老黄来站台| 图片来源:极客公园

02

新工具

作为 Google Cloud 托管的 AI 工具部署平台,Vertex AI 也在今天得到了几乎是「全模态」的更新,新的视频、图像、语音和音乐生成 AI 工具都将登陆 Vertex AI。

其中最值得关注的,就是视频生成模型 Veo 2 的更新,新增的编辑和相机控制功能,除了可以自动「从视频中移除不需要的背景图像、徽标或干扰物」。还能将原始视频的画面扩展,进一步填充原本的空白内容。这个工具会用 AI 生成的、能与原始片段融合的视频素材来填充新的空间。

Veo 2 的视频内容拓展效果 | 图片来源:Google

此次更新还允许 Veo 2 用户在生成素材时,除了文本描述外,还可以选择电影技巧预设,用于指导最终结果中的镜头构图、摄像机角度和节奏。包括延时摄影效果、无人机风格的第一人称视角(POV)以及模拟不同方向的摄像机平移。

此外,本次更新还增加了一个新的插值(Interpolation)功能,可以在两个静态图像之间创建视频过渡,用新的帧填充开头和结尾序列。

只需给出一个起始帧和最终帧,Veo 2 就会生成连接两者的视频。

只需两张照片,Veo 2 就能自动生成一段中间视频 | 图片来源:Google

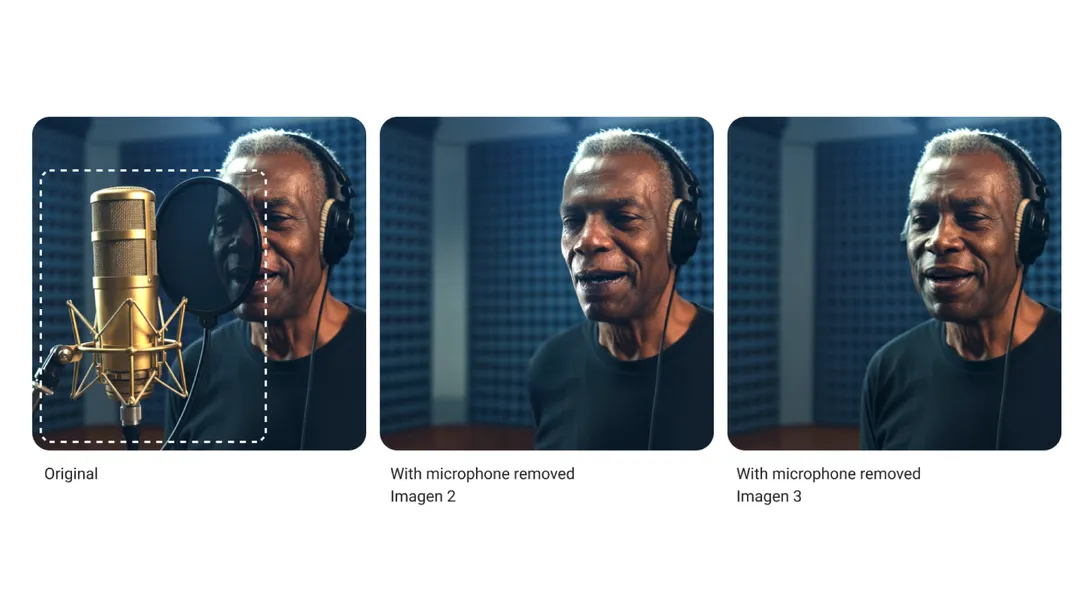

文本转图像模型 Imagen 3 的编辑功能也得到了更新,Google 表示本次更新「显著」改进了自动对象移除时的自然效果。

Imagen 3 能获得更自然的内容移除效果 | 图片来源:Google

据现场相关业务负责人介绍,Veo 2 和 Imagen 3 已经被欧莱雅等公司用于设计营销内容。负责人 Justin Thomas 表示,过去「需要八周才能完成的图像处理任务,现在只需八小时」。

这些更新发布之后,使 Vertex AI 成为目前市面上唯一一个覆盖了视频、图像、语音和音乐的内容生成模型的平台。

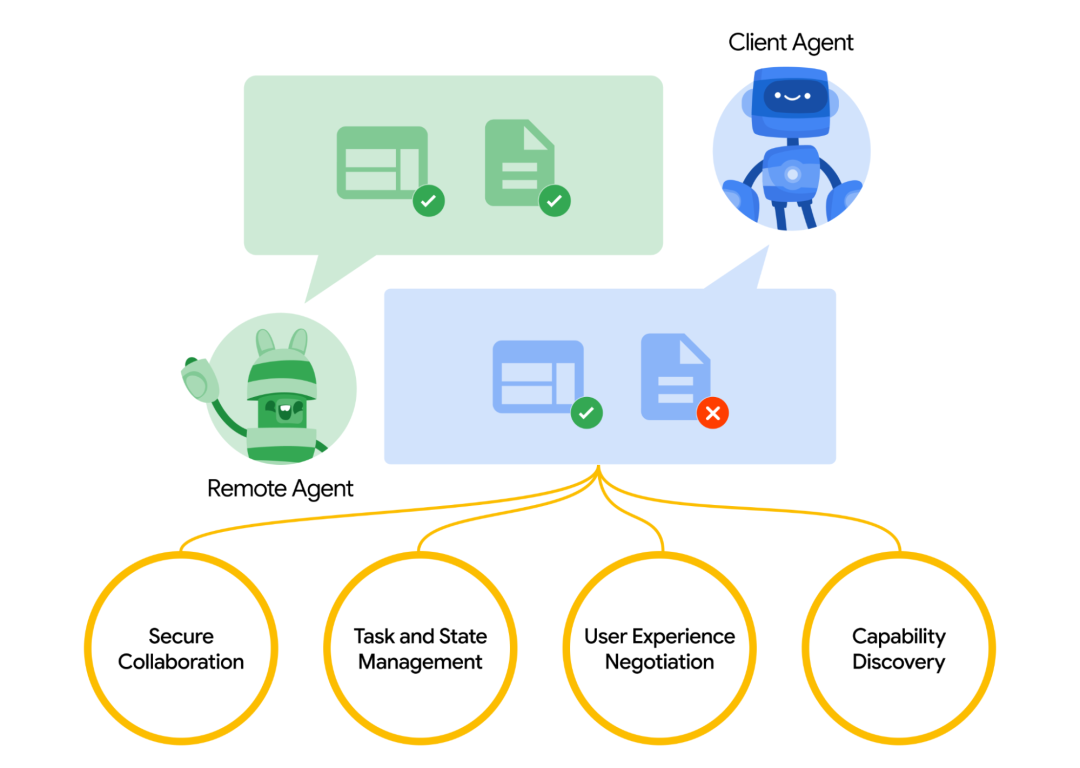

除了面向当下需求的新工具,Google 还公布了一项新的开放协议——Agent2Agent (A2A),旨在连接不同生态系统中的 AI Agents。

这个概念听起来似乎与时下非常流行的 MCP 协议有些相似之处,但不同之处在于,MCP 是为了解决 LLM 与工具之间的沟通,而 A2A 则是 Agent 与 Agent 之间的对话,就像是属于 AI 的全新语言。

A2A 协议应用场景演示 | 图片来源:Google

Google 表示,A2A 协议将使企业能够更便捷地部署 AI Agent 产品,因为它解决了构建在不同供应商生态系统上的代理无法相互通信的挑战。

在现场,还演示了一个具体的案例:例如在同一个 UI 界面下,系统可以使用一个 Agent 来根据位置与技能,在面试中筛选候选人,在筛选完成、并且完成初步的面试后,系统可以自动将生成的信息快速传输给另一个设计用于候选人背景审查的 AI Agent 工具,在这个过程中,大幅降低 AI 与 AI 之间的信息损耗。

这套系统显然在未来越来越多 AI Agent 投入应用的时代,有着很强的需求。根据代理式数字工作平台 DoozerAI 的联合创始人 Paul Chada 的说法,A2A 协议提供的互操作性将使企业能够自动化跨越多个系统的复杂工作流程,从而可能在降低集成成本的同时提高生产力。

Google 同时还介绍,A2A 协议建立在现有流行的标准之上,包括 HTTP、SSE 和 JSON-RPC;其中 HTTP 是网络通信的基础,而 SEE 和 JSON-RPC 分别是向客户端服务器发送更新的基础协议,以及应用程序使用 JSON 消息进行远程相互通信的基础协议。

尽可能多的利用现有的协议,目标是能够尽可能降低这个全新的协议,在现有服务中部署的难度,使其更容易与企业已在使用的现有 IT 堆栈集成。即使这仍然是一个短期内充满挑战的事,但仍然让现场的不少开发者感到兴奋,随处可以听到关于这个「Agent 之间的新语言」的讨论。

03

新硬件

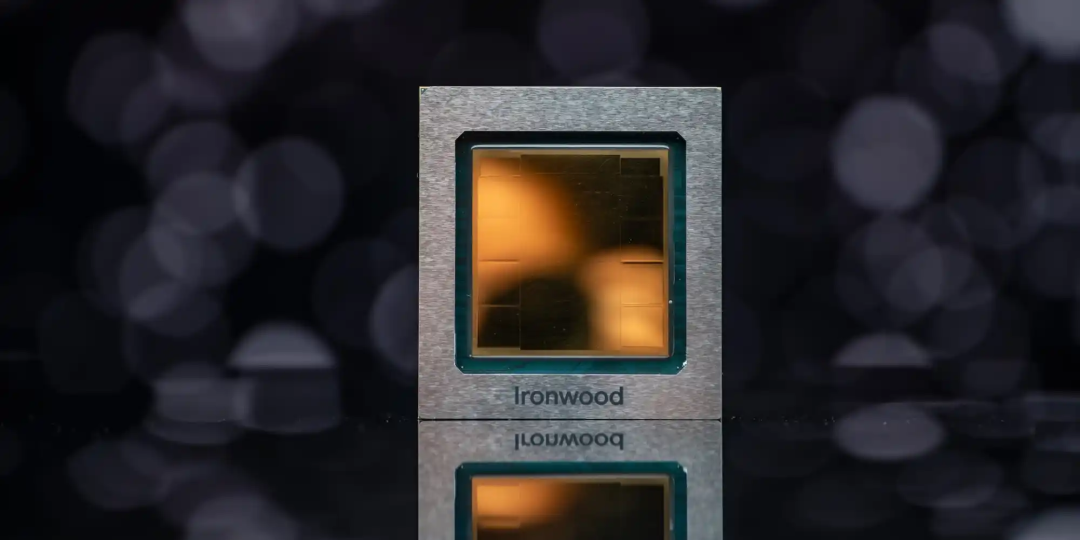

对于 Google 来讲,在 AI 领域的统治级地位,除了提供完善的软件能力,在硬件领域多年的投入带来的成果如同左右手一般必不可少,因此今天除了一系列软件服务更新,Google 今天还发布了最新的第七代 Tensor 处理单元(TPU)Ironwood。

Ironwood TPU | 图片来源:Google

据 Google 介绍,Ironwood TPU 是 Google「迄今为止性能最强、可扩展性最高且能效最高的定制 AI 加速器」,并且是「首款专为推理设计」的 TPU。

Ironwood 每个独立芯片提供 4614 TFLOPs 的峰值计算能力。而包括 9216 颗 TPU 的集群总共拥有 42.5 Exaflops 的计算能力,是世界上目前最大的超级计算机 El Capitan(每个集群提供 1.7 Exaflops)计算能力的 24 倍以上。

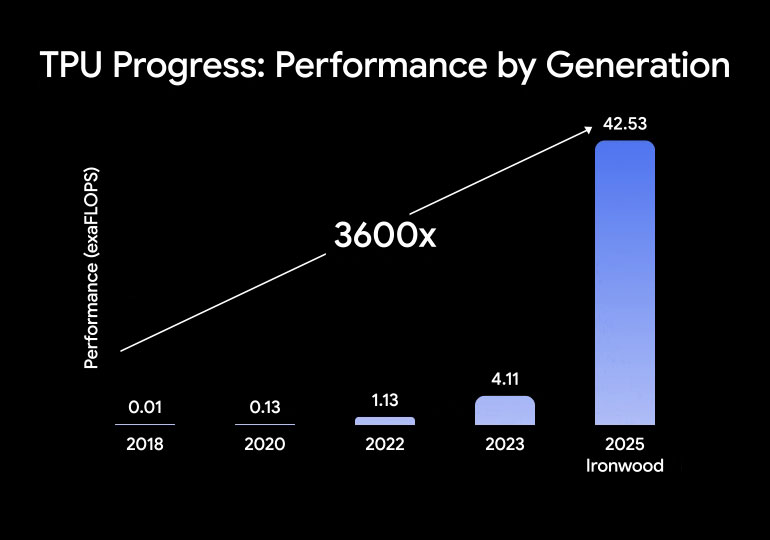

如果这还不足以直观的体现 Ironwood 性能的蒙正,作为云计算 TPU 硬件领域的大厂,Google 还回顾了从 2018 年到 2025 年的研发历程 ——TPU 的性能增长了 3600 倍。

第七代 TPU Ironwood 有着巨大的性能提升 | 图片来源:Google

据 Google 介绍,性能巨幅提升的 Ironwood,旨在针对性满足思维模型所要求的不同计算需求,这些模型「包括大型语言模型(LLM)、混合专家模型(MoE)和需要「大规模」并行处理和高效的内存访问的高级推理任务」。

在前沿领域,思维模型的计算需求远远超出了任何单个芯片的能力。因此我们设计的 Ironwood TPU 具有低延迟、高带宽的 ICI 网络,以支持在整个 TPU 单元级规模上进行协调、同步的通信。

04

结语

当你看到这篇文章时,Google Cloud Next 25 的主题演讲已经结束,但正式的会议日程才刚刚开始。

就像本次 Next 25 的口号一样,来这里的每个人都想知道「AI for what's next?」的答案,主题演讲中发布的一系列工具,只是 Google Cloud 对此的回答。

每个来到这里的人,都在试图找到「AI for what's next」这个问题的答案 | 图片来源:极客公园

作为当下最大的「AI 基础设施」供应商,Google Cloud 不仅需要提供更多现有的工具:更好的模型能力,更丰富的平台、更适合的算力硬件。

在市面上,你几乎再也难以找到像 Google Cloud 这样,给用户提供了「一站式解决方案」的厂商,因此在现场的沟通中,「One and only」是现场很多开发者的声音。

「一站式解决方案」|图片来源:极客公园

Google 在 AI 领域的地位,也让 Google Cloud Next 作为沟通平台的价值急剧提升,在前沿技术的土壤中,作为「AI 时代的基础设施」,帮助更多用户,建立起更多满足新时代需求的 AI 生态,或许才是 Google Cloud 未来的「核心价值」。